目次

- 14.1. MySQL Cluster の概要

- 14.2. 基本的な MySQL Cluster のコンセプト

- 14.3. 簡単なマルチ コンピューターの手引き

- 14.4. MySQL Cluster の設定

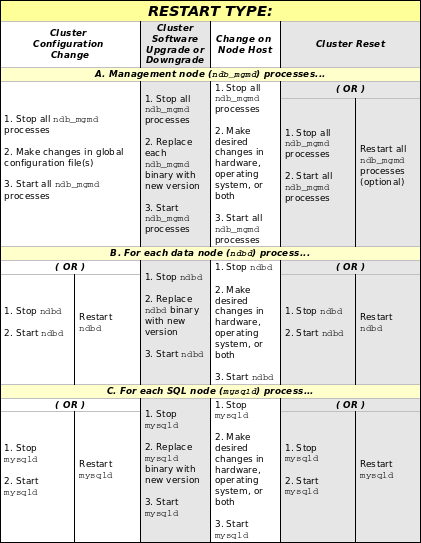

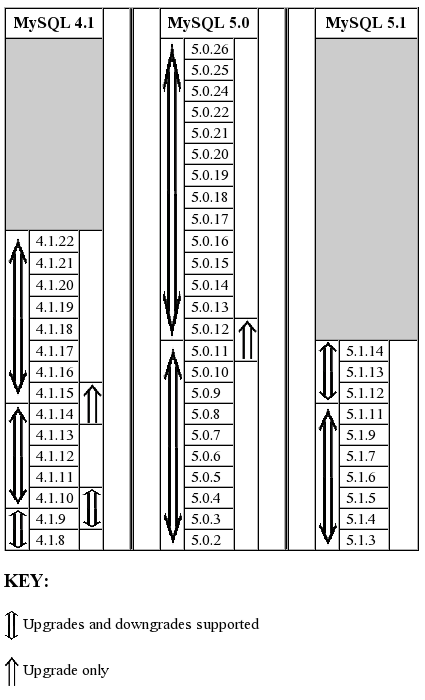

- 14.5. MySQL Cluster のアップグレードおよびダウンロード

- 14.6. MySQL Cluster のプロセス管理

- 14.7. MySQL Cluster の管理

- 14.8. MySQL Cluster のオンライン バックアップ

- 14.9. クラスタ ユーティリティ プログラム

- 14.9.1. ndb_config ? NDB 設定情報の抽出

- 14.9.2. ndb_delete_all ? NDB テーブルからのすべての行を削除する

- 14.9.3. ndb_desc ? NDB テーブルの説明

- 14.9.4. ndb_drop_index

- 14.9.5. ndb_drop_table

- 14.9.6. ndb_error_reporter

- 14.9.7. ndb_print_backup_file

- 14.9.8. ndb_print_schema_file

- 14.9.9. ndb_print_sys_file

- 14.9.10. ndb_select_all

- 14.9.11. ndb_select_count

- 14.9.12. ndb_show_tables

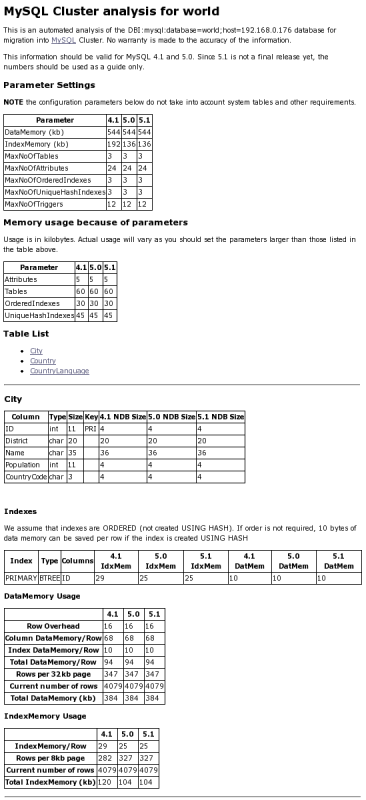

- 14.9.13. ndb_size.pl ? NDBCluster サイズ仕様エスティメーター

- 14.9.14. ndb_waiter

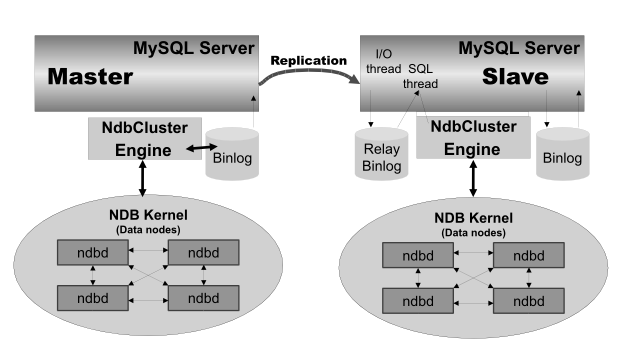

- 14.10. MySQL Cluster レプリケーション

- 14.11. MySQL Cluster ディスク データ ストレージ

- 14.12. MySQL Cluster での高速インターコネクトを使用する

- 14.13. MySQL Cluster の既知の制限

- 14.14. MySQL Cluster 開発ロードマップ

- 14.15. MySQL Cluster の用語

コンパイル時の不手際のため、MySQL 5.1.12のバイナリ配布にはNDBクラスタやパーティショニングは含まれませんでした。ご不便をお掛けし恐縮です。バージョン5.1.14.へ更新してください。ソースからコンパイルする場合には、--with-ndbcluster、--with-partitionオプションとともにconfigureを実行して下さい。

MySQL Cluster は MySQL

の高可用性、高冗長性バージョンで分散型コンピュータ環境に採用されています。MySQL

Cluster はクラスタで数台の MySQL

サーバーを動作させるための NDB

Cluster ストレージ

エンジンを使用しています。このストレージ

エンジンは MySQL 5.1 バイナリ

リリースおよび最新の Linux 分散型互換の RPM

で利用できます。

MySQL Cluster は現在利用可能で以下のプラットフォームでサポートされています。

Linux:x86、AMD64、EMT64、s/390、PPC、Alpha、SPARC、UltraSparc

Solaris:SPARC、UltraSparc、x86、AMD64、EMT64

BSD (FreeBSD、NetBSD、OpenBSD):x86、AMD64、EMT64、PPC

Mac OS X:PPC

HP-UX:PA-RISC

Tru64:Alpha

OpenVMS:Alpha

IRIX:MIPS

Novell Netware:x86

QNX Neutrino:x86

SCO OpenServer、OpenUnix、UnixWare:x86

特定のオペレーティング システムのバージョンの組み合わせ、、オペレーティング システムの流通、およびハードウェア プラットフォームでの MySQL Cluster の適格なサポート レベルについては、MySQL AB のウェブ サイトの MySQL のサポートチームが維持しているCluster Supported Platforms list を参照してください。

MySQL Cluster は現在 Microsoft Windows ではサポートされて いません。 弊社では MySQL がサポートする Windows を含むすべてのオペレーティング システムでクラスタを利用できるように目指しており、ここに掲載した情報を開発の進捗に応じて更新して参ります。

本章では現在進行中の作業について説明し、その内容は MySQL Cluster の開発の進捗に応じて改訂します。MySQL Cluster に関する詳細は MySQL AB のウェブサイト http://www.mysql.com/products/cluster/ を参照してください。

その他のリソース

クラスタに関するよく出る質問に関する回答は 項A.11. 「MySQL 5.1 FAQ ? MySQL Cluster」 に掲載してあります。

MySQL Cluster のメーリング リスト: http://lists.mysql.com/cluster.

MySQL Cluster フォーラム: http://forums.mysql.com/list.php?25.

多くの MySQL Cluster ユーザーや MySQL Cluster の開発者の中にはクラスタの経験をブログし、それらの経験を PlanetMySQL で共有できるようになっています。

MySQL Cluster を初めてお使いになる場合には、弊社の開発者ゾーンの記事 How to set up a MySQL Cluster for two servers がお役に立つかと思います。

MySQL Cluster は非共有システム (shared-nothing system) での in-memory データベースのクラスタを可能にするテクノロジです。非共有システムのアーキテクチャでは非常に廉価なハードウェアで最低限のハードウェアあるいはソフトウェアの特殊仕様でシステムを構築できます。

MySQL Cluster を使用することで一極集中型不具合(シングル ポイント オブ ファイリュア)を回避できます。これを実現するため、各コンポーネントはそれぞれ自身のメモリとディスクを持ち、ネットワーク共有、ネットワーク ファイルシステム、および SAN などの共有ストレージに使用は推奨もしくはサポートしていません。

MySQL Cluster は NDB と呼ばれる in-memory

のクラスタ ストレージ エンジンで標準の MySQL

サーバーを統合しています。弊社の説明資料では、NDB

という用語はストレージ

エンジンに特化した設定を意味し、そこでは

「MySQL Cluster」 は MySQL および

NDB ストレージ

エンジンの組み合わせを意味しています。

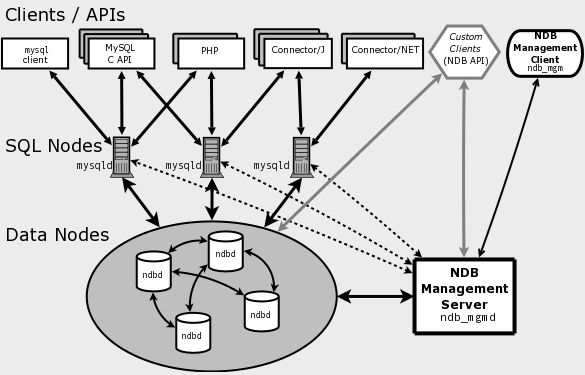

MySQL Cluster は MySQL サーバー、データノード、マネジメント サーバー、および(多分に)特定のデータ アクセス プログラムを含む 1つあるいはそれ以上のプロセスをそれぞれ動作させるコンピュータの組み合わせで構築されます。以下にクラスタでのこれらのコンポーネントの関係を示します。

これらのすべてのプログラムは一緒に動作して

MySQL Cluster を構築します。データが NDB

Cluster ストレージ

エンジンに保持されると、テーブルはデータノードに保持されます。それらのテーブルはクラスタのすべての他の

MySQL

サーバーから直接アクセスできます。このように、クラスタに保持された給料計算のアプリケーションでは、一つのアプリケーションで一人の社員の給料を更新すると、このデータをクエリする他のすべての

MySQL サーバーで瞬時のこの変更を表示できます。

MySQL Cluster のデータノードに保持されたデータはミラーされます。クラスタはトランザクションの状態を見失うことによる少数のトランザクションの失敗以外影響を受けずに個々のデータノードの不具合を処理します。なぜなら、トランザクション関係のアプリケーションはトランザクション処理がその目的にあるため、これは問題の根源にはなり得ないからです。

NDB

は高可用性およびデータ堅牢性を提供する

in-memory のストレージ エンジンです。

NDB ストレージ

エンジンは一定のフェールオーバーおよび負荷分散の環境で構築できますが、ストレージ

エンジンをクラスタ

レベルで始めるのが無難です。MySQL Cluster の

NDB ストレージ

エンジンは完全なデータセットを含み、クラスタ内の他のデータのみに依存します。

MySQL Cluster のクラスタ部分は現在 MySQL サーバーとは個別に設定されています。MySQL Cluster では、クラスタの各部を ノード と呼んでいます。

注:多くの説明書では、用語の 「ノード」 はコンピュータに意味に使われていますが、MySQL Cluster の説明ではノードは プロセス を意味します。一台のコンピュータでのノードは幾つも操作できるので、弊社では クラスタ ホスト を用語に使用しています。

(しかし、MySQL は現在は生産環境の設定ではまだ一台のコンピューターで複数のデータノードをサポートしていませんのでその点ご留意ください。詳細は、Issues exclusive to MySQL Clusterを参照してください。)

クラスタ ノードは 3 種類あり、最小の MySQL Cluster の設定では、最低 3 台のノードを使用し、以下の種類になります。

マネジメント ノード (MGM ノード):この種のノードはの役割は MySQL Cluster 内の他のノードを管理し、設定データなどの機能を実行し、ノードを起動あるいは停止したりバックアップなどを行います。この種のノードは他のノードの設定を管理するため、この種のノードは他のノードより先に起動する必要があります。MGM ノードは コマンド ndb_mgmd で起動します。

データノード:この種のノードはクラスタのデータを保持します。レプリカにフラグメントを乗算した分の多くのデータノードがあります。例えば、2 つのレプリカがあれば、各レプリカには 2 つのフラグメントがあるため、4 つのデータノードが必要になります。1 つ以上のレプリカを持つ必要はありません。データノードはコマンド ndbd で起動します。

SQL ノード:これはクラスタ データにアクセスするノードです。MySQL Cluster の場合、SQL ノードは

NDB Clusterストレージ エンジンを使用した従来の MySQL サーバーです。SQL ノードは一般的には mysqld --ndbcluster または、my.cnfに追加したndbclusterオプションとで mysqld を使用して起動します。SQL ノードは実際は単に API ノード の特化版でクラスタ データにアクセスするアプリケーションを意味します。API ノードの一つの例としてはクラスタのバックアップの保持に使用される ndb_restore ユーティリティがあります。NDB API を使用してそのようなアプリケーションを記述できます。

重要生産環境では 3 台のノード設定の使用を期待するのは現実的ではありません。そのような設定は冗長性に欠け、MySQL Cluster の高可用性の機能を活かすには、複数のデータノードおよび SQL ノードを使用する必要があります。複数のマネジメント ノードの使用も強くお勧めします。

MySQL Cluster のノード、ノード グループ、レプリカ、およびパーテッションの関係に関する概説は、項14.2.1. 「MySQL Cluster ノード、ノード グループ、レプリカ、およびパーテッション」 を参照してください。

クラスタの構築にはクラスタの各個々のノードの設定およびノード間の個々の通信リンクの設定が含まれます。MySQL Cluster は現在データノードがプロセッサの性能、メモリ スペース、および帯域において均一になるよう開発しています。さらに、一元管理の設定を提供するために、クラスタのすべての設定データは全体として一つの設定ファイルに格納されています。

マネジメント サーバー (MGM ノード) はクラスタの設定ファイルおよびクラスタ ログを管理します。クラスタの各ノードはマネジメント サーバーから設定データを取り出し、マネジメント サーバーが常駐する場所を決める方法を要求します。データノードで何か珍しいイベントが発生すると、ノードはこれらのイベントの情報をマネジメント サーバーに伝送し、マネジメント サーバーがその情報をクラスタ ログに書き込みます。

さらに、クラスタのクライアント プロセスおよびアプリケーションはどんな数でも利用できます。これらには 2 種類あります。

標準の MySQL クライアント:標準 (非クラスタ)の MySQL 以外の違いは MySQL Cluster でもありません。換言すれば、MySQL Cluster は PHP、Perl、C、C++、Java、Python、Ruby などで記述された既存の MySQL アプリケーションからアクセスできます。

マネジメント クライアント:これらのクライアントはマネジメント サーバーと接続してノードを厳かに始動・停止し、メッセージの追跡(デバッグ バージョンのみ)を始動・停止し、ノードのバージョンおよび状態を表示し、バックアップを始動・停止しするなどのコマンドを提供します。

この項では MySQL Cluster によるストレージ用のデータの分割または複製方法について説明します。

この件で特に理解していただきたいのは以下のコンセプトで、簡単な定義と共にここに一覧にまとめました。

(データ) ノード:ndbd プロセスは レプリカ ?を保持します。つまり そのノードが構成要素であるノード グループに割り当てられた パーテッション (以下参照) のコピーです。

各データノードは個別のコンピューターに配置される必要があります。1 台のコンピューターで複数の ndbd プロセスをホストできますが、そのような設定はサポートしていません。

用語の 「ノード」 や 「データノード」 のは一般的には ndbd プロセスを意味する場合にはどちらも使用できますが、マネジメント (MGM) ノード (ndb_mgmd プロセス) および SQL ノード (mysqld プロセス) はこの説明ではそのように指定されます。

ノード グループ:ノードグループは 1 つ以上のノードで構成され、パーテッション、あるいはレプリカ (次のアイテム参照) のセットを保持します。

注:現在は、クラスタのすべてのノード グループは同数のノードを持つ必要があります。

パーテッション:これはクラスタで保持されているデータの一部です。クラスタのノードのパーテッション数ほどのクラスタのパーテッション数があります。各ノードはクラスタで利用できるノードに割り当てられた少なくともパーテッションのコピー 1 つ (つまり、少なくても 1 つのレプリカ) を維持する役目があります。

レプリカはすべて 1 つのノードに属します。ノードはいくつかのレプリカを保持(通常保持する)できます。

レプリカ:これはクラスタのパーテッションのコピーです。ノード グループの各ノードはレプリカを 1 つ保存します。パーテッション レプリカと呼ばれる場合もあります。ノードグループ毎のレプリカの数はノードの数に一致します。

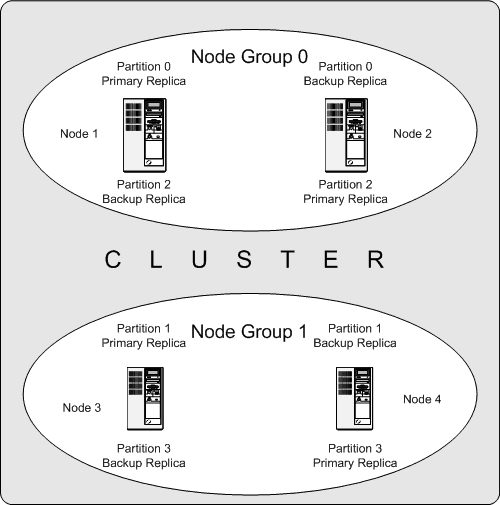

以下はそれぞれ 2 つのノードを持つ 2 つのノード グループを配置した 4 つのデータノードを持つ MySQL Cluster の図です。ノード 1 およびノード 2 はノード グループ 0 に属し、ノード 3 とノード 4 はノード グループ 1 に属します。ここではデータ (ndbd) ノードのみ示しています。実際に使用されるクラスタではクラスタの管理に ndb_mgm プロセスとクラスタに保持されているデータにアクセスするための少なくとも 1 つの SQL ノードが必要ですが、分かり易くするためにここでは省略しています。

クラスタが保持するデータは 0、1、2、3 の番号を付いた 4 つのパーテッションに分割されます。各パーテッションは同じノード グループの?複数のコピー?に保持されます。パーテッションは交互にノードグループに保持存されます。

パーテッション 0 はノードグループ 0 に保持されます。プライマリ レプリカ (プライマリ コピー) はノード 1 に保持されます。バックアップ レプリカ (パーテッションのバックアップ コピー) はノード 2 に保持されます。

パーテッション 1 は別のノード グループ(ノード グループ 1) に保持されます。このパーテッションのプライマリ レプリカはノード 3、そのバックアップ レプリカはノード 4 の保持されます。

パーテッション 2 はノードグループ 0 に保持されます。しかし、2 つのレプリカの配置はパーテッション 0 と逆になります。パーテッション 2 では、プライマリ レプリカはノード 2 に保持され、バックアップはノード 1 に保持されます。

パーテッション 3 はノードグループ 1 に保存され、その 2 つのレプリカの配置はパーテッション 1 のそれと逆になります。つまり、プライマリ レプリカはノード 4 に配置され、バックアップはノード 3 に配置されます。

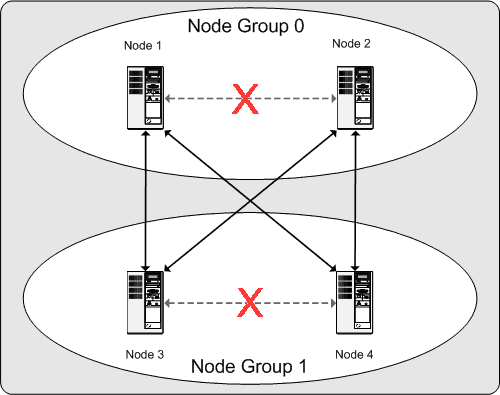

MySQL Cluster の継続的なオペレーションに関してこの意味するところは以下のようになります。クラスタで使用される各ノード グループが動作している少なくとも 1 つのノードを持つ限り、クラスタはすべてのデータの完全なコピーを持ち実行可能であり続けます。これを次の図に示します。

この例では、クラスタがそれぞれ 2 つのノードを持つ 2 つのノード グループで構成されている場合、すくなくともノード グループ 0 に 1 つのノードおよび少なくともノード グループ 1 の 1 つのノードの組み合わせでクラスタを 「有効」 に維持します(図の矢印で示した部分)ことができます。しかし、どちらかのノードグループの両方のノードが失敗した場合、残りの 2 つのノードでは不十分(X の印の付いた矢印)です。どちらの場合も、クラスタは全体のパーテッションを失いすべてのクラスタのデータの完全なセットのアクセスを提供できなくなります。

この項は「手引書」 で MySQL Cluster の計画、インストール、設定、および運営に関して説明します。その一方で 項14.4. 「MySQL Cluster の設定」 の例では様々なクラスタの構築および設定について詳しく説明します。ここで説明するガイドラインおよびプロシージャを実行することによって可用性およびデータの安全に必要な 最低の条件を満たした運用可能な MySQL Cluster を構築できます。

この項ではハードウェアおよびソフトウェア要件;ネットワークの問題、MySQL Cluster のインストール、設定の問題、起動、停止、およびクラスタの再起動;サンプル データベースのローディング、並びにクエリの実行について説明します。

基本的な仮定条件

この手引書は以下の仮定条件に基づいています。

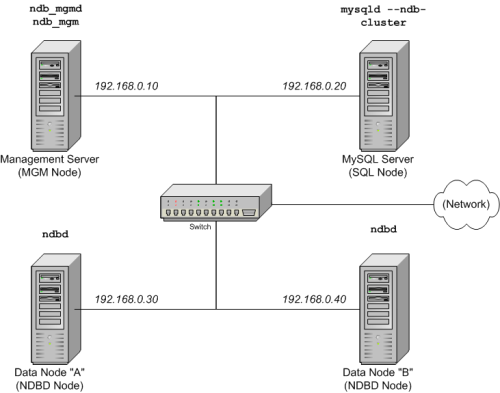

クラスタの設定には 4 台のノードを使用し、それぞれ個別のホストで、以下に示すように一般的な Ethernet 上の固定ネットワーク アドレスを持っていいます。

ノード IP アドレス マネジメント (MGM) ノード 192.168.0.10 MySQL サーバー (SQL) ノード 192.168.0.20 データ (NDBD) ノード "A" 192.168.0.30 データ (NDBD) ノード "B" 192.168.0.40 以下の図で詳しく説明します。

注:分かり易く (および信頼性) するのために、この手引書では数値の IP アドレスのみ使用しています。しかし、お客様のネットワークの DNS 分割が可能な場合、クラスタを設定する際に IP アドレスの代わりホスト名を使用することができます。また、

/etc/hostsファイルあるいは利用可能な場合お客様のオペレーティング システム相当するものを使用してホストの自動照合を行う手段を提供することもできます。このシナリオの各ホストはインテル ベースのディスクトップ PC で、標準設定の不必要なサービスの要らないディスクにインストールした一般的な Linux 分散型で行っています。標準の TCP/IP ネットワーク機能を備えたコアの OS で十分です。簡略化するために、すべてのホストのファイルシステムは全く同じものを使用しています。ファイルシステムが同じでない場合、以下の指示に従がう必要があります。

標準の 100 Mbps あるいは 1 ギガビットの Ethernet カードをそのカードの適切なドライバを使用して各マシンにインストールしています。4 台のすべてのホストはスイッチなどの標準の Ethernet ネットワーク機器を使用して接続しています。(すべてのマシンは同じスループットのネットワーク カードを使用する必要があります。つまり、クラスタの 4 台のすべてのマシンは 100 Mbps カードあるいは 4 台のすべてのマシンは 1 Gbps カードを使用する必要があります。)MySQL Cluster は 100 Mbps のネットワークで動作します。しかし、ギガビットの Ethernet を使用するとパフォーマンスが向上します。

MySQL Cluster は 100 Mbps 以下のスループットのネットワークで使用されるようには設計されて おりませんのでこの点ご留意願います。このため(とりわけ)、MySQL Cluster をインターネットなどの公共のネットワークを使用しても多分うまく行かないし、またまた推奨していません。

サンプルのデータ用に、弊社では

worldデータベースを使用します。それは MySQL AB のウェブ サイトからダウンロードできます。このデータベースは比較的スペースが小さいので、弊社では各マシンは 256MB RAM あれば、オペレーティング システム、ホスト NDB プロセス、および(データノード用)データベースの保持に十分であると考えています。

この手引書では Linux オペレーティング システムにを採り上げていますが、ここでの説明およびプロシージャは他のサポートしているオペラーティング システムにも転用できます。弊社ではお客様が既にネットワーク機能を備えたオペレーティング システムの最低限のインストールおよび設定をご存知で、必要に応じてこの件に関する支援をどこからでも得られるものであるという前提で説明しています。

次項では MySQL Cluster のハードウェア、ソフトウェア、およびネットワーク要件についてさらに突っ込んだ説明をします。(項14.3.1. 「ハードウェア、ソフトウェア、およびネットワークの構築」 参照。)

MySQL Cluster の利点の 1 つは通常のハードウェアで動作し、すべての生きたデータ ストレージは in-memory で行われるので、大容量の RAM 以外にこの点に関し特別な仕様を必要としないということです。(これはディスク データ テーブルには適用されません。? この点に関する詳細は 項14.11. 「MySQL Cluster ディスク データ ストレージ」 を参照してください。)当然のことながら、マルチの高速 CPU はパフォーマンスを強化します。他のクラスタ プロセスで必要なメモリは比較的小さくて済みます。

クラスタに必要なソフトウェア要件もまた穏やかなものです。MySQL Cluster をサポートするホストのオペレーティング システムには特別なモジュール、サービス、アプリケーション、あるいは設定の必要はありません。サポートしているオペレーティング システムには、標準のインストールで十分です。MySQL のソフトウェア要件は簡素です。今必要なものはクラスタをサポートした量産用の SQL 5.1 のリリースだけです。単にクラスタに使用するためにだけにお客様ご自身で MySQL をコンパイルする必要はありません。この手引書では、MySQL ソフトウェア ダウンロード ページ http://dev.mysql.com/downloads/ で入手可能なお客様のオペレーティング システムに適したサーバー バイナリを使用しているものとしてこの説明を続けます。

ノード間通信には、クラスタは TCP/IP ネットワークを標準のトポロジでサポートしており、各ホストに必要な最低条件は標準の 100 Mbps Ethernet カード、それにクラスタ全体の接続を提供するスイッチ、ハブ、あるいはルータです。弊社では以下の理由により MySQL Cluster が非クラスタ マシンを共有していない個別のサブネットで実行されることを強くお勧めします。

セキュリティ:クラスタ ノード間の通信は暗号化あるいはシールドされていません。MySQL Cluster 内での伝送保護の唯一の方法はお客様のクラスタを保護されたネットワークで運用することです。MySQL Cluster をウェブ アプリケーションに使用する場合には、クラスタは必ずファイアウォールの内側に常駐させ、ネットワークの のDe-Militarized (DMZ) ゾーンあるいはそのような場所に常駐させないでください。

効率:MySQL Cluster をプライベートあるいは保護されたネットワークに設定することでクラスタのホスト間の帯域を排他的に使用できます。個別のスイッチを MySQL Cluster の使用することでクラスタのデータへの無許可のアクセスから保護するだけでなく、ネットワーク上の他のコンピュータ間の伝送による干渉からクラスタ ノードをシールドできます。信頼性を向上させるには、デュアルのスイッチおよびデュアルのカードを使用して一極集中型不具合 (シングル ポイントのファイリュア) からネットワークを守ることがでます。多くのデバイス ドライバがそのような通信リンクのフェールオーバーをサポートしています。

MySQL Cluster に高速のスケーラブル コヒーラント インターフェース (SCI) を使用することもできます。これは必要条件ではありません。このプロトコルおよびその MYSQL Cluster での使用方法については 項14.12. 「MySQL Cluster での高速インターコネクトを使用する」 を参照してください。

データあるいは SQL ノードを実行する各 MySQL Cluster のホスト コンピュータには MySQL サーバーバイナリをインストールする必要があります。マネジメント ノードには MySQL サーバーバイナリをインストールする必要はありませんが、MGM サーバーデーモンおよびクライアント バイナリ (それぞれ ndb_mgmd および ndb_mgm) をインストールする必要があります。この項では各種のクラスタ ノードに適切なバイナリをインストールするために必要なステップについて説明します。

MySQL AB

ではクラスタをサポートするコンパイル済みのバイナリを提供していますので、通常これらをお客様ご自身でコンパイルする必要はありません。ですから、各クラスタ

ホストのインストール

プロセスの最初のステップはファイル

mysql-5.1.15-beta-pc-linux-gnu-i686.tar.gz

を MySQL downloads

area

からダウンロードすることです。それを各マシン

/var/tmp

ディレクトリに配置したものと想定します。(カスタムのバイナリが必要な場合には、

項2.9.3. 「開発ソース ツリーからのインストール」

を参照してください。)

RPM も 32 ビットおよび 64 ビットの Linux プラットフォームに利用できます。MySQL Cluster 1 台につき 4 つのRPM が必要です。

サーバー RPM (例えば、

MySQL-server-5.1.15-beta-0.glibc23.i386.rpm) は、 MySQL サーバーの動作に必要なコア ファイルを提供します。サーバー/Max RPM (例えば、

MySQL-Max-5.1.15-beta-0.glibc23.i386.rpm) は、MySQL サーバーにクラスタをサポートしたバイナリを提供します。NDB Cluster - ストレージ エンジン RPM (例えば、

MySQL-ndb-storage-5.1.15-beta-0.glibc23.i386.rpm) は、MySQL Cluster にデータノード バイナリ (ndbd) を提供します。NDB Cluster - ストレージ エンジン マネジメント RPM (例えば、

MySQL-ndb-management-5.1.15-beta-0.glibc23.i386.rpm) は MySQL Cluster にマネジメント サーバーバイナリ (ndb_mgmd) を提供します。

さらに、NDB Cluster

を取得する必要があります - ストレージ

エンジンの基本ツール RPM

(例えば、MySQL-ndb-tools-5.1.15-beta-0.glibc23.i386.rpm)

は、MySQL Cluster

で使用するいくつかの有用なアプリケーションを提供します。これらのうちで重要なものは

MySQL Cluster マネジメント クライアント

(ndb_mgm) です。NDB

Cluster - ストレージ エンジン予備ツール

RPM

(例えば、MySQL-ndb-extra-5.1.15-beta-0.glibc23.i386.rpm)

は、いくつかの追加テストおよびモニタリングのプログラムが含まれていますが、MySQL

Cluster

のインストールには必要ありません。(これらの追加プログラムの詳細に関しては、項14.9. 「クラスタ ユーティリティ プログラム」

を参照してください。)

RPM ファイル名 (5.1.15-beta

として表示) の MySQL

のバージョン番号は実際に使用するバージョンによって変わります。インストールするすべてのクラスタ

RPM の MySQL

バージョン番号が同じであることが非常に重要です。glibc

バージョン番号 (使用している場合 ?

glibc23

として表示)、およびアーキテクチャ名

(i386 として表示) は RPM

をインストールするマシンに適したものであることが必要です。

MySQL AB 供給の RPM を使用した MySQL をインストールに関する一般情報は、 項2.4. 「Linux に MySQL をインストールする」 を参照してください。

RPM のパッケージをインストールした後、さらに 項14.3.3. 「マルチ コンピュータの設定」 で説明するクラスタを設定する必要があります。

注:インストールを完了しても、まだどのバイナリも起動しないでください。すべてのノードの設定が終了した段階で、起動の仕方を説明します。

データおよび SQL

ノードのインストール ?

.tar.gz バイナリ

データあるいは SQL

ノードのホスト用の各マシンで、システム

root

ユーザーとして以下のステップを踏みます。

/etc/passwdおよび/etc/groupファイル (あるいはユーザーおよびグループを管理のためのお客様のオペレーティング システムで提供されたツール) をチェックし、mysqlグループおよびmysqlユーザーがシステムに既に用意されているか確認します。OS の ディストリビューションの中にはこれらをオペレーティング システムのインストール プログラムとして作成している場合もあります。それらがまだ作成されていない場合、新たにmysqlユーザーグループを作成し、mysqlユーザーをこのグループに追加します。shell>

groupadd mysqlshell>useradd -g mysql mysqluseradd および groupadd の文法は Unix のバージョンによって多少異なる場合があり、またadduser および addgroup などの別な名前を使用している場合もあります。

ダウンロードしたファイルを含むディレクトリにロケーションを変更し、アーカイブを開いて、

mysqlに symlink を作成します。実際のファイル名およびディレクトリ名は MySQL のバージョン番号によって異なる場合があります。shell>

cd /var/tmpshell>tar -C /usr/local -xzvf mysql-5.1.15-beta-pc-linux-gnu-i686.tar.gzshell>ln -s /usr/local/mysql-5.1.15-beta-pc-linux-gnu-i686 /usr/local/mysqlロケーションを

mysqlディレクトリに変更し、供給されたスクリプトを実行してシステムのデータベースを作成します。shell>

cd mysqlshell>scripts/mysql_install_db --user=mysqlMySQL サーバーおよびデータ ディレクトリに必要な許可を設定します。

shell>

chown -R root .shell>chown -R mysql datashell>chgrp -R mysql .データノードをホストしている各マシンのデータ ディレクトリは

/usr/local/mysql/dataであることを確認します。マネジメント ノードを設定する際にこの情報が必要になります。(項14.3.3. 「マルチ コンピュータの設定」 参照。)適切なディレクトリに MySQL 起動スクリプトをコピーし、実行できる状態にし、オペレーティング システムがブートしたときに起動できるように設定します。

shell>

cp support-files/mysql.server /etc/rc.d/init.d/shell>chmod +x /etc/rc.d/init.d/mysql.servershell>chkconfig --add mysql.server(起動スクリプトのディレクトリはオペレーティング システムおよびバージョンによって異なる場合があり? 例えば、 いくつかの Linux ディストリビューションの場合、それは

/etc/init.dとなります。)ここでは起動スクリプトのリンクの作成に Red Hat の chkconfig を使用します。Debian の update-rc.d などお客様のオペレーティング システムおよびディストリビューションでこの目的に適切と思われるものを使用します。

データノードおよび SQL ノードが常駐する各マシンで前に説明したステップを個別に実行する必要がありますので忘れずに実行してください。

SQL ノードのインストール ? RPM ファイル

クラスタ SQL ノードをホストに使用する各マシンで、以下のコマンドをシステムのルート ユーザーとして実行して MySQL Max RPM をインストールし、RPM に表示された名前を必要に応じて MySQL AB のウェブサイトからダウンロードした RPM に一致する名前に置き換えます。

shell>rpm -Uhv MySQL-server-5.1.15-beta-0.glibc23.i386.rpmshell>rpm -Uhv MySQL-Max-5.1.15-beta-0.glibc23.i386.rpm

これによりインストールに必要なすべての MySQL

サポート ファイルおよび MySQL

サーバーバイナリ (mysqld) を

/usr/sbin

ディレクトリにインストールします。これにより

mysql.server および

mysqld_safe 起動スクリプトもまた

/usr/share/mysql および

/usr/bin

にそれぞれインストールします。RPM

インストーラが一般的な設定の操作を

(必要に応じて mysql

ユーザーおよびグループの作成)

を自動的に実行します。

データノードのインストール ? RPM ファイル

クラスタのデータノードをホストするコンピュータには NDB Cluster - ストレージ エンジン RPM のみをインストールする必要があります。インストールするには、この RPM をデータノードのホストにコピーし、以下のコマンドをシステム ルートのユーザーとして実行し、RPM に表示された名前を必要に応じて MySQL AB のウェブサイトからダウンロードした RPM に一致する名前に置き換えます。

shell> rpm -Uhv MySQL-ndb-storage-5.1.15-beta-0.glibc23.i386.rpm

前のコマンドで MySQL Cluster データノード

バイナリ (ndbd) を

/usr/sbin

ディレクトリにインストールします。

マネジメント

ノードのインストール ?

.tar.gz バイナリ

(MGM) ノードのインストールには

mysqld

バイナリをインストールする必要はありません。MGM

サーバーとクライアントにのみバイナリが必要で、それはダウンロードしたアーカイブにあります。再度このファイルを

/var/tmp

に配置したか確認します。

システム root

(つまり、sudo、su

root、あるいはお客様のシステムで相当するものを一時的にシステムの管理者のアカウント権限として)として、

以下のステップを実行して ndb_mgmd

および ndb_mgm を Cluster

マネジメント

ノードのホストにインストールします。

ロケーションを

/var/tmpディレクトリに変更して、ndb_mgm および ndb_mgmd をアーカイブから/usr/local/binなどの適切なディレクトリに抽出します。shell>

cd /var/tmpshell>tar -zxvf mysql-5.1.15-beta-pc-linux-gnu-i686.tar.gzshell>cd mysql-5.1.15-beta-pc-linux-gnu-i686shell>cp /bin/ndb_mgm* /usr/local/bin(ダウンロードしたアーカイブを開いたときに作成されたディレクトリとそれが含んでいるファイルを

/var/tmpから、 ndb_mgm および ndb_mgmd が実行可能なディレクトリにコピーされたら削除できます。ファイルをコピーしたディレクトリにロケーションを変更し、次にその両方を実行出来るようにします。

shell>

cd /usr/local/binshell>chmod +x ndb_mgm*

マネジメント ノードのインストール ? RPM ファイル

MySQL Cluster マネジメント サーバーをインストールするには、NDB Cluster - ストレージ エンジン マネジメント RPM のみを使用する必要があります。この RPM をマネジメント ノードをホストするコンピュータにコピーし、次にそれを以下のコマンドをシステム ルートのユーザー(RPM に表示された名前を必要に応じて MySQL AB ウェブサイトからダウンロードしたストレージ エンジン マネジメント RPM に一致する名前に置き換えます) としてインストールします。

shell> rpm -Uhv MySQL-ndb-management-5.1.15-beta-0.glibc23.i386.rpm

これによりマネジメント サーバーバイナリ

(ndb_mgmd) を /usr/sbin

ディレクトリにインストールします。

また ストレージ

エンジン基本ツール RPM で供給された

NDB マネジメント

クライアントをインストールする必要があります。この

RPM をマネジメント

ノードと同じコンピュータにコピーし、次にそれを以下のコマンドをシステム

ルートのユーザー(再度、RPM

に表示された名前を必要に応じて MySQL AB ウェブ

サイトからダウンロードしたストレージ

エンジン基本ツール RPM

に一致する名前に置き換えます)

としてインストールします。

shell> rpm -Uhv MySQL-ndb-tools-5.1.15-beta-0.glibc23.i386.rpm

ストレージ

エンジンの基本ツール RPM は MySQL Cluster

マネジメント クライアント

(ndb_mgm) を /usr/bin

ディレクトリにインストールします。

項14.3.3. 「マルチ コンピュータの設定」 で、弊社の参考クラスタですべてのノードに設定ファイルを作成します。

4 ノード、4 ホスト MySQL Cluster には ノード毎に 1 つずつ 4 つの設定ファイルを書く必要があります。

各データ ノードあるいは SQL ノードは 2 種類の情報を提供する

my.cnfファイルが必要です。ノードに MGM ノードの所在を知らせる接続文字列、および NDB モードでこのホスト(データノードをホストしているマシン)の MySQL サーバーに実行を告げる行。接続文字列に関する詳細は、項14.4.4.2. 「クラスタの

接続文字列」 を参照してください。マネジメント ノードは維持するレプリカの数量、各データ ノードのデータおよびインデックスのメモリ容量、データ ノードをどこで探すか、各データ ノードのディスクのデータの保存場所、どこで SQL ノードを探すかなどを告げる

config.iniファイルが必要とします。

ストレージおよび SQL ノードの設定

データ ノードが必要とするmy.cnf

ファイルはかなり簡素です。設定ファイルは

/etc

ディレクトリにあり、テキスト

エディタで編集できることが必要です。(ない場合にはファイルを作成します。)例えば:

shell> vi /etc/my.cnf

ここではファイルを作成するために vi が使用しますが、どのテキスト エディタも同様に機能する必要があります。

弊社の模範設定での各データノードおよび SQL

ノードに対し my.cnf

は以下のようになります。

# Options for mysqld process: [MYSQLD] ndbcluster # run NDB storage engine ndb-connectstring=192.168.0.10 # location of management server # Options for ndbd process: [MYSQL_CLUSTER] ndb-connectstring=192.168.0.10 # location of management server

上記の情報を入力後、このファイルを保存しテキスト エディタを終了します。これをデータノード 「A」、データ ノード 「B」、および SQL ノードをホストしているマシンに行います。

重要前述のように

mysqld プロセスを

my.cnf の [MYSQLD]

にある ndbcluster および

ndb-connectstring

パラメータで実行すると、CREATE

TABLE あるいは ALTER TABLE

ステートメントをクラスタを実際に起動するまで実行できなくなります。または、これらのステートメントはエラーが表示されて失敗します。これは設計によります。

マネジメント ノードの設定

MGM

ノードを設定する最初のステップは、設定ファイルを格納するディレクトリを作成し、次にファイルそのものを作成します。例えば

(root としてを実行する):

shell>mkdir /var/lib/mysql-clustershell>cd /var/lib/mysql-clustershell>vi config.ini

弊社の見本設定では、config.ini

ファイルは以下のようになります。

# Options affecting ndbd processes on all data nodes:

[NDBD DEFAULT]

NoOfReplicas=2 # Number of replicas

DataMemory=80M # How much memory to allocate for data storage

IndexMemory=18M # How much memory to allocate for index storage

# For DataMemory and IndexMemory, we have used the

# default values. Since the "world" database takes up

# only about 500KB, this should be more than enough for

# this example Cluster setup.

# TCP/IP options:

[TCP DEFAULT]

portnumber=2202 # This the default; however, you can use any

# port that is free for all the hosts in cluster

# Note: It is recommended beginning with MySQL 5.0 that

# you do not specify the portnumber at all and simply allow

# the default value to be used instead

# Management process options:

[NDB_MGMD]

hostname=192.168.0.10 # Hostname or IP address of MGM node

datadir=/var/lib/mysql-cluster # Directory for MGM node log files

# Options for data node "A":

[NDBD]

# (one [NDBD] section per data node)

hostname=192.168.0.30 # Hostname or IP address

datadir=/usr/local/mysql/data # Directory for this data node's data files

# Options for data node "B":

[NDBD]

hostname=192.168.0.40 # Hostname or IP address

datadir=/usr/local/mysql/data # Directory for this data node's data files

# SQL node options:

[MYSQLD]

hostname=192.168.0.20 # Hostname or IP address

# (additional mysqld connections can be

# specified for this node for various

# purposes such as running ndb_restore)

(注:world

データベースは http://dev.mysql.com/doc/ の

「例題設定」

のリストからダウンロードできます。)

すべての設定ファイルを作成してこれらの最低限のオプションを指定すると、クラスタを実行する準備が整い、すべてのプロセスが動作していることを検証できます。これをどのように行うか 項14.3.4. 「最初の起動」 で説明します。

利用できる MySQL Cluster の設定パラメータおよびその使用方法の詳細については 項14.4.4. 「設定ファイル」、および 項14.4. 「MySQL Cluster の設定」 を参照してください。バックアップに関する MySQL Cluster の設定については、項14.8.4. 「クラスタ バックアップの設定」 を参照してください。

注:クラスタ マネジメント ノードのデフォルトのポートは 1186で、データ ノードのデフォルトのポートは 2202 です。MySQL 5.0.3 以降ではこの制限が解除されており、クラスタはすでにフリーになっているものから自動的にデータ ノードにポートを割り当てます。

設定後のクラスタの稼動はそれほど難しくありません。各クラスタ ノードはクラスタが常駐するホストで個別に起動します。マネジメント ノードを最初に起動し、次にデータノード、最後に SQL ノードを起動します。

マネジメント ホストでシステム シェルから以下のコマンドを発行し、MGM ノード プロセスを実行します。

shell>

ndb_mgmd -f /var/lib/mysql-cluster/config.inindb_mgmd に

-fあるいは--config-fileオプションを使用して設定ファイルの場所を知らせる必要があります。(詳細は 項14.6.3. 「ndb_mgmd、マネジメント サーバープロセス」 を参照してください。)各データ ノードのホストで、このコマンドを実行して最初の ndbd プロセスを始めます。

shell>

ndbd --initial--initialパラメータのみを ndbd を最初に実行するとき、あるいはバックアップ/復旧作業あるいは設定変更後に起動したときに使用することが非常に重要ですのでこの点留意してください。これは--initialオプションによってノードがリカバリのログファイルを含むリカバリに必要な ndbd インスタンスで以前作成したファイルを削除するからです。この例外は

--initialは ディスク データ ファイルは削除しないということです。クラスタの最初の再起動を実行する必要がある場合、既存のディスク データのログファイルおよびデータ ファイルを手動で削除する必要があります。SQL ノードが常駐するクラスタのホストに MySQL をインストールするために RPM ファイルを使用した場合には、SQL ノードで MySQL サーバープロセスを実行するには供給された起動スクリプトを使用(する必要がある)できます。

すべてが上手くいってクラスタが正しく設定できたら、この段階でクラスタを使用できます。ndb_mgm マネジメント ノード クライアントを起動してこれをテストできます。その出力は以下になる必要があります。使用している MySQL のバージョンによって出力が多少異なる場合もあります。

shell>ndb_mgm-- NDB Cluster -- Management Client -- ndb_mgm>SHOWConnected to Management Server at: localhost:1186 Cluster Configuration --------------------- [ndbd(NDB)] 2 node(s) id=2 @192.168.0.30 (Version: 5.1.15-beta, Nodegroup: 0, Master) id=3 @192.168.0.40 (Version: 5.1.15-beta, Nodegroup: 0) [ndb_mgmd(MGM)] 1 node(s) id=1 @192.168.0.10 (Version: 5.1.15-beta) [mysqld(SQL)] 1 node(s) id=4 (Version: 5.1.15-beta)

注:SQL

ノードはここでは [mysqld(API)]

として使用しています。これは完全に通常で、mysqld

プロセスがクラスタ API

ノードの役割を果たしていることを表しています。

この段階でMySQL クラスタのデータベース、テーブル、およびデータを使用できる準備ができました。簡単な説明については、項14.3.5. 「サンプル データのローディングとクエリの実行」 を参照してください。

MySQL Cluster のデータの作業はクラスタ無しの MySQL で行うのとそれほど違いはありません。考慮すべき点が 2 点あります。

クラスタでコピーするテーブルはには、

NDB Clusterストレージ エンジンを使用する必要があります。これを指定するにはENGINE=NDBあるいはENGINE=NDBCLUSTERテーブル オプションを使用します。テーブルを作成する際にこのオプションを追加できます。CREATE TABLE

tbl_name( ... ) ENGINE=NDBCLUSTER;代わりに、異なるストレージ エンジンを使用している既存のテーブルに対して、

ALTER TABLEを使用してテーブルを変更してNDB Clusterを使用できます。ALTER TABLE

tbl_nameENGINE=NDBCLUSTER;各

NDBテーブルにはプライマリ キーが必要です。ユーザーがテーブルを作成したときにプライマリ キーを定義しなかった場合、NDB Clusterストレージ エンジンが自動的に非表示のテーブルを生成します。(注:この非表示のテーブルは他のテーブル インデックスと同じスペースを使用します。メモリ不足のためにこれらの自動的に作成されたインデックスを使用する際に問題に遭遇することは普通ではありません。

mysqldump

の出力を使用して既存のデータベースからテーブルをインポートする場合、テキスト

エディタの SQL

スクリプトを開きテーブルの作成ステートメントに

ENGINE

オプションを追加します。あるいは既存の

ENGINE (あるいは TYPE)

オプションを置き換えます。MySQL Cluster

をサポートしていない別の MySQL サーバーに

world

サンプルのデータベースを持っていて、City

テーブルをエクスポートするとします。

shell> mysqldump --add-drop-table world City > city_table.sql

その結果の city_table.sql

ファイルはテーブルの作成ステートメント(およびテーブル

データをインポートするために必要な

INSERT ステートメント)

を含みます。

DROP TABLE IF EXISTS `City`;

CREATE TABLE `City` (

`ID` int(11) NOT NULL auto_increment,

`Name` char(35) NOT NULL default '',

`CountryCode` char(3) NOT NULL default '',

`District` char(20) NOT NULL default '',

`Population` int(11) NOT NULL default '0',

PRIMARY KEY (`ID`)

) ENGINE=MyISAM DEFAULT CHARSET=latin1;

INSERT INTO `City` VALUES (1,'Kabul','AFG','Kabol',1780000);

INSERT INTO `City` VALUES (2,'Qandahar','AFG','Qandahar',237500);

INSERT INTO `City` VALUES (3,'Herat','AFG','Herat',186800);

(remaining INSERT statements omitted)

MySQL が NDB ストレージ

エンジンをこのテーブルに使用していることを確認する必要があります。この確認の方法は

2 つあります。その 1 つは Cluster

データベースにインポートする前

before

にテーブルの定義を変更することです。例として

City

テーブルを使用し、以下のように定義の

ENGINE オプションを変更します。

DROP TABLE IF EXISTS `City`;

CREATE TABLE `City` (

`ID` int(11) NOT NULL auto_increment,

`Name` char(35) NOT NULL default '',

`CountryCode` char(3) NOT NULL default '',

`District` char(20) NOT NULL default '',

`Population` int(11) NOT NULL default '0',

PRIMARY KEY (`ID`)

) ENGINE=NDBCLUSTER DEFAULT CHARSET=latin1;

INSERT INTO `City` VALUES (1,'Kabul','AFG','Kabol',1780000);

INSERT INTO `City` VALUES (2,'Qandahar','AFG','Qandahar',237500);

INSERT INTO `City` VALUES (3,'Herat','AFG','Herat',186800);

(remaining INSERT statements omitted)

クラスタ

テーブルの一部になる各テーブルの定義にこれを行う必要があります。これを行うための最も簡単な方法は定義を含むファイルに検索および置き換えを実行し、TYPE=

あるいは

engine_nameENGINE=

のすべてのインスタンスを

engine_nameENGINE=NDBCLUSTER

で置き換えることです。ファイルの変更を希望しない場合には、変更していないファイルを使用してテーブルを作成し、次に

ALTER TABLE を使用してストレージ

エンジンを変更します。この項の後で詳細を説明します。

クラスタの SQL ノードで world

と呼ばれるデータベースを既に作成したとして、mysql

コマンド ライン クライアントを使用して

city_table.sql

を読み込み、そして次にいつもの方法で相当するテーブルを作成して移植します。

shell> mysql world < city_table.sql

前述のコマンドを SQL

ノードを実行している(この場合、IP

アドレスが 192.168.0.20 のマシンで)

ホストで忘れないで実行することが非常に重要です。

SQL ノードで world

全体のデータベースのコピーを作成するには、非クラスタ

サーバーの mysqldump

を使用してデータベースをファイル名

world.sql

にエクスポートします。例えば、/tmp

のティレクトりで行います。次にテーブルの定義を今説明したように変更し、以下のようにクラスタの

SQL ノードにそのファイルをインポートします。

shell> mysql world < /tmp/world.sql

ファイルを別のロケーションに保存した場合、前述の説明をしかるべく調整します。

MySQL の NDB Cluster が 5.1

データベースのオートディスカバリをサポートしていないことを忘れずに覚えておくことがが重要です。(項14.13. 「MySQL Cluster の既知の制限」

参照。)このことは、データ

ノードでworld

データベースおよびそのテーブルを作成したら、CREATE

SCHEMA world

ステートメントを発行する必要があることを意味しています。

SELECT クエリを SQL

ノードで実行することは MySQL

サーバーの他のインスタンスで実行するのと違いはありません。。コマンドラインからクエリを実行するには、最初に

MySQL Monitor にいつもの方法 (root

パスワードを Enter

password:プロンプトで指定します)

でログインします。

shell> mysql -u root -p

Enter password:

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 1 to server version: 5.1.15-beta

Type 'help;' or '\h' for help. Type '\c' to clear the buffer.

mysql>

弊社では単純に MySQL サーバーの

root

アカウントを使用していますが、お客様は My SQL

サーバーのインストールの際は堅固な

root

パスワードの設定を含む標準的なセキュリティ対策を講じているものと想定しています。詳細は

項2.10.3. 「最初の MySQL アカウントの確保」

を参照してください。

クラスタ ノードがお互いにアクセスするときに

MySQL

権限システムを使用しないことを考慮する必要があります。MySQL

ユーザーアカウント(root

アカウントを含む)の設定あるいは変更によって、ノード間のインターラクションに影響を及ぼさず、SQL

ノードにアクセスするアプリケーションにのみ影響を及ぼします。

SQL

スクリプトのインポートに先立ちテーブル定義の

ENGINE

節を変更しなかった場合、この時点で以下のステートメントを実行する必要があります。

mysql>USE world;mysql>ALTER TABLE City ENGINE=NDBCLUSTER;mysql>ALTER TABLE Country ENGINE=NDBCLUSTER;mysql>ALTER TABLE CountryLanguage ENGINE=NDBCLUSTER;

データベースを選択してそのデータベースのテーブルに対する SELECT クエリの実行も既存の MySQL Monitor と同様に通常の方法で実現できます。

mysql>USE world;mysql>SELECT Name, Population FROM City ORDER BY Population DESC LIMIT 5;+-----------+------------+ | Name | Population | +-----------+------------+ | Bombay | 10500000 | | Seoul | 9981619 | | Sao Paulo | 9968485 | | Shanghai | 9696300 | | Jakarta | 9604900 | +-----------+------------+ 5 rows in set (0.34 sec) mysql>\qBye shell>

MySQL を使用しているアプリケーションは標準の

API で NDB

テーブルにアクセスします。Iお客様のアプリケーションが、MGM

あるいはデータノードではなく SQL

ノードにアクセスすることを憶えておくことが重要です。この簡単な例ではネットワーク上の

Web サーバーで動作している PHP 5 の

mysqli

拡張を使用した場合のようにどのように

SELECT

ステートメントを実行するかを示しています。

<!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN"

"http://www.w3.org/TR/html4/loose.dtd">

<html>

<head>

<meta http-equiv="Content-Type"

content="text/html; charset=iso-8859-1">

<title>SIMPLE mysqli SELECT</title>

</head>

<body>

<?php

# connect to SQL node:

$link = new mysqli('192.168.0.20', 'root', 'root_password', 'world');

# parameters for mysqli constructor are:

# host, user, password, database

if( mysqli_connect_errno() )

die("Connect failed: " . mysqli_connect_error());

$query = "SELECT Name, Population

FROM City

ORDER BY Population DESC

LIMIT 5";

# if no errors...

if( $result = $link->query($query) )

{

?>

<table border="1" width="40%" cellpadding="4" cellspacing ="1">

<tbody>

<tr>

<th width="10%">City</th>

<th>Population</th>

</tr>

<?

# then display the results...

while($row = $result->fetch_object())

printf(<tr>\n <td align=\"center\">%s</td><td>%d</td>\n</tr>\n",

$row->Name, $row->Population);

?>

</tbody

</table>

<?

# ...and verify the number of rows that were retrieved

printf("<p>Affected rows: %d</p>\n", $link->affected_rows);

}

else

# otherwise, tell us what went wrong

echo mysqli_error();

# free the result set and the mysqli connection object

$result->close();

$link->close();

?>

</body>

</html>

Web サーバー上で実行されているプロセスが SQL ノードの IP アドレスにアクセスできるものとします。

同様に、MySQL C API、Perl-DBI、Python-mysql、あるいは MySQL AB の自身のコネクタを使用してデータ定義および操作のタスクを MySQL で行うのと同様に実行できます。

クラスタをシャットダウンするには、MGM ノードをホストしているマシンのシェルに以下のコマンドを入力します。

shell> ndb_mgm -e shutdown

ここの-e

オプションがコマンドをシェルから

ndb_mgm

クライアントに渡すために使用されます。項3.3.1. 「コマンドラインにおけるオプションの使用」

参照。そのコマンドが

ndb_mgm、ndb_mgmd、および他の

ndbd プロセスを終了させます。SQL

ノードは mysqladmin shutdown

および他の方法でショットダウンできます。

クラスタを再起動するには、これらのコマンドを使用します。

マネジメント ホスト (

192.168.0.10サンプル設定):shell>

ndb_mgmd -f /var/lib/mysql-cluster/config.ini各データ ノードのホスト (

192.168.0.30および192.168.0.40):shell>

ndbdNDBD ノードを通常に再起動する際にはこのコマンドを

--initialオプションで実行しない ことを憶えておいてください。SQL ホスト (

192.168.0.20):shell>

mysqld &

クラスタのバックアップを取るには 項14.8.2. 「バックアップを作成するためのマネジメント クライアントの使用」 を参照してください。

クラスタをバックアップから復旧するには ndb_restore コマンドを使用する必要があります。これは 項14.8.3. 「クラスタのバックアップの復旧方法」 で説明しています。

MySQL Cluster の設定の詳細は 項14.4. 「MySQL Cluster の設定」 で入手できます。

MySQL Cluster を構成する MySQL サーバーが通常

(非クラスタ) の MySQL サーバーと 1

点異なります。それは NDB Cluster

ストレージ

エンジンを搭載していることです。このエンジンは単に

NDB とも言われ、その 2

つの名前は同じ意味です。

リソースの不必要な割り当てを避けるために、サーバーはデフォルトで

NDB ストレージ

エンジンを無効に設定しています。NDB

を有効にするには、サーバーの

my.cnf

設定ファイルを変更するか、またはサーバーを

--ndbcluster オプションで起動します。

MySQL

サーバーはクラスタの構成要素の一部ですので、クラスタの設定データを取得するには

MGM

ノードへのアクセス方法を知る必要があります。デフォルトでは

MGM ノードを localhost

で探します。しかし、そのロケーションの場所を指定する必要がある場合には、my.cnf、

あるいは MySQL

サーバーのコマンドラインでできます。NDB

ストレージ

エンジンを使用する前に、所望のデータ

ノードはもとより少なくとも MGM ノードを 1

つ動作できるようにしておく必要があります。

NDB、つまりクラスタ ストレージ

エンジンはバイナリのディストリビューションで

Linux、Mac OS X、および Solaris

で利用できます。現在 Windows を含む MySQL

でサポートするすべてのオペレーティング

システムでクラスタを動作できるように作業しています。

ソース tarball あるいは MySQL 5.1 BitKeeper

ツリーからの構築を選択する場合、--with-ndbcluster

オプションを configure

を実行する際必ず使用してください。BUILD/compile-pentium-max

ビルド

スクリプトを使用することもできます。このスクリプトは

OpenSSL

が含まれているため、構築を成功裏に終わるにはオープン

SSL

を使用するかあるいは取得する必要があります。あるいは、compile-pentium-max

を変更して要件を外します。勿論、ご自身のバイナリにコンパイルするには標準の手順に説明書に従い、次に通常のテストおよびインストール

プロシージャを実行します。項2.9.3. 「開発ソース ツリーからのインストール」

参照。

次の数項で MySQL のインストール方法には習熟されると思いますので、ここでは MySQL Cluster の設定および非クラスタの MySQL の違だけにいつて説明します。(後者について詳細は、章?2. MySQL のインストールと更新 を参照してください。)

すべてのマネジメント

ノードおよびデータノードを最初に起動しているとクラスタの設定が非常に簡単だということが分かります。これは設定の中でもっとの時間にかかる部分です。my.cnf

ファイルの編集はとても簡単です。この項では非クラスタの

MySQL の設定との違いについてのみ説明します。

基本に習熟して頂くために、最も簡単な MySQL Cluster の実用面の設定について説明します。これが終了すると、本章の関連する項で提供された情報に従ってお客様のご所望の設定が出来るようになります。

最初に、/var/lib/mysql-cluster

のような設定ディレクトリを作成する必要があります。それを作成するには以下のコマンドをシステム

root ユーザーとして実行します。

shell> mkdir /var/lib/mysql-cluster

このディレクトリで以下の情報を含む

config.ini

と呼ばれるファイルを作成します。必要に応じてお客様のシステムに適切な値を

HostName および DataDir

に入力します。

# file "config.ini" - showing minimal setup consisting of 1 data node, # 1 management server, and 3 MySQL servers. # The empty default sections are not required, and are shown only for # the sake of completeness. # Data nodes must provide a hostname but MySQL Servers are not required # to do so. # If you don't know the hostname for your machine, use localhost. # The DataDir parameter also has a default value, but it is recommended to # set it explicitly. # Note: DB, API, and MGM are aliases for NDBD, MYSQLD, and NDB_MGMD # respectively. DB and API are deprecated and should not be used in new # installations. [NDBD DEFAULT] NoOfReplicas= 1 [MYSQLD DEFAULT] [NDB_MGMD DEFAULT] [TCP DEFAULT] [NDB_MGMD] HostName= myhost.example.com [NDBD] HostName= myhost.example.com DataDir= /var/lib/mysql-cluster [MYSQLD] [MYSQLD] [MYSQLD]

ndb_mgmd この段階でマネジメント

サーバーを起動できます。デフォルトでは

config.ini

ファイルを現在動作しているディレクトリから読み込もうとしますので、ファイルが存在するディレクトリに変更して、ndb_mgmd

を起動します。

shell>cd /var/lib/mysql-clustershell>ndb_mgmd

次に ndbd

を実行してシングルのデータ

ノードを起動します。ndbd

を所定のデータノードにまさに初めて起動するには、以下のに示す

--initial

オプションを使用する必要があります。

shell> ndbd --initial

その後の ndbd

の起動では、普通は--initial

オプションを省き

たいと思うでしょう

shell> ndbd

--initial

をその後の再起動で省く理由はこのオプションでは

ndbd

がこのデータノードの既存のすべてのデータおよびログ

ファイルを削除し、新たにそれらを作成するからです。--initial

を最初の ndbd

起動以外に使用しないこの規則の例外はそれをクラスタを起動するときに使用し、新しいデータ

ノードを追加した後にバックアップから保存することです。

デフォルトでは、ndbd

はマネジメント サーバーをポート 1186 の

localhost で探します。

注:MySQL をバイナリの

tarball

からインストールした場合には、ndb_mgmd

および ndbd

サーバーのパスを明示的に指定する必要があります。(通常、これらは

/usr/local/mysql/bin にあります。)

最後に、ロケーションを MySQL データ

ディレクトリ (通常 /var/lib/mysql

あるいは /usr/local/mysql/data)

に変更し、my.cnf ファイルが NDB

ストレージ

エンジンに起動に必要なオプションが含まれているか確認します。

[mysqld] ndbcluster

この段階で MySQL サーバーを従来通りに起動できます。

shell> mysqld_safe --user=mysql &

MySQL

サーバーが適切に動作しているか確認するために少し待ちます。mysql

ended

との通知が表示された場合には、サーバーの.err

ファイルをチェックして何が間違っているか調べます。

ここまですべてが問題なく動作した場合、この段階でクラスタを使用して起動できます。サーバーに接続して

NDBCLUSTER ストレージ

エンジンが有効であることを確認します。

shell>mysqlWelcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is 1 to server version: 5.1.15-beta Type 'help;' or '\h' for help. Type '\c' to clear the buffer. mysql>SHOW ENGINES\G... *************************** 12. row *************************** Engine: NDBCLUSTER Support: YES Comment: Clustered, fault-tolerant, memory-based tables *************************** 13. row *************************** Engine: NDB Support: YES Comment: Alias for NDBCLUSTER ...

前述の参考例の出力で表示された行番号はサーバーの設定によってお客様のシステムに表示されたものと異なる場合があります。

NDBCLUSTER テーブルの作成

shell>mysqlmysql>USE test;Database changed mysql>CREATE TABLE ctest (i INT) ENGINE=NDBCLUSTER;Query OK, 0 rows affected (0.09 sec) mysql>SHOW CREATE TABLE ctest \G*************************** 1. row *************************** Table: ctest Create Table: CREATE TABLE `ctest` ( `i` int(11) default NULL ) ENGINE=ndbcluster DEFAULT CHARSET=latin1 1 row in set (0.00 sec)

お客様のノードが適切に設定されているか確認するには、マネジメント クライアントを起動します。

shell> ndb_mgm

クラスタのステータスのレポートを取得するにはマネジメント クライアントの SHOW コマンドを使用します。

NDB> SHOW

Cluster Configuration

---------------------

[ndbd(NDB)] 1 node(s)

id=2 @127.0.0.1 (Version: 3.5.3, Nodegroup: 0, Master)

[ndb_mgmd(MGM)] 1 node(s)

id=1 @127.0.0.1 (Version: 3.5.3)

[mysqld(API)] 3 node(s)

id=3 @127.0.0.1 (Version: 3.5.3)

id=4 (not connected, accepting connect from any host)

id=5 (not connected, accepting connect from any host)

この段階で、実働可能な MySQL Cluster

の設定を完了しました。ここで

ENGINE=NDBCLUSTER あるいはその別名

ENGINE=NDB

で作成されたテーブルを使用してクラスタのデータを保存できます。

MySQL を設定には 2 つのファイルの作業が伴います。

my.cnf:すべての MySQL Cluster 実行ファイルにオプションを指定します。このファイルは MySQL のこれまでの説明で既に習熟していると思いますが、クラスタで使用されている各実行ファイルからアクセスできる必要があります。config.ini:このファイルは MySQL Cluster マネジメント サーバーによってのみ読み込まれ、クラスタで使用されているすべてのプロセスにそこに含まる情報を配布します。config.iniにはクラスタに使用されている各ノードの説明が含まれます。これにはデータ ノードの設定パラメータおよびクラスタのすべてのノード間接続の設定パラメータが含まれています。このファイルに表示されるセクションを素早く参照したり、各セクションにどんな種類の設定パラメータが含まれているを調べるにはconfig.iniFile を参照してください。

弊社では継続的にクラスタの設定を改善しており、また現在このプロセスを簡素化する作業に携わっています。弊社では以前のバージョンとの互換性維持に努めていますが、互換性の無い変更が行われる場合もあります。そのような場合には弊社では変更によって以前のバージョンとの互換性が無くなる旨を事前niクラスタのユーザーに連絡するつもりです。お客様がそのような変更に気付いても弊社で文書化していない場合、項1.7. 「質問またはバグの報告」 にある指示に従ってそれを MySQL のバグ データベースに報告お願いします。

MySQL Cluster をサポートするには

my.cnf

を以下の例に基づいて更新する必要があります。ここに示すオプションを

config.ini

ファイルに使用したオプションと混同しないように注意してくだささい。実行ファイルを実行する際にコマンドラインでこれらのパラメータを指定することもっできます。

# my.cnf # example additions to my.cnf for MySQL Cluster # (valid in MySQL 5.1) # enable ndbcluster storage engine, and provide connectstring for # management server host (default port is 1186) [mysqld] ndbcluster ndb-connectstring=ndb_mgmd.mysql.com # provide connectstring for management server host (default port: 1186) [ndbd] connect-string=ndb_mgmd.mysql.com # provide connectstring for management server host (default port: 1186) [ndb_mgm] connect-string=ndb_mgmd.mysql.com # provide location of cluster configuration file [ndb_mgmd] config-file=/etc/config.ini

(接続文字列に関する詳細は、項14.4.4.2. 「クラスタの 接続文字列」

を参照してください。)

# my.cnf # example additions to my.cnf for MySQL Cluster # (will work on all versions) # enable ndbcluster storage engine, and provide connectstring for management # server host to the default port 1186 [mysqld] ndbcluster ndb-connectstring=ndb_mgmd.mysql.com:1186

重要前述のように

mysqld プロセスを

my.cnf ファイルの

[MYSQLD] にある

ndbcluster および

ndb-connectstring

パラメータで実行すると、CREATE

TABLE あるいは ALTER TABLE

ステートメントをクラスタを実際に始めるまでは実行できなくなります。または、これらのステートメントはエラーが表示されて失敗します。これは設計によります。

クラスタ のmy.cnf

ファイルの個別の [mysql_cluster]

セクションを使用して設定を読み込んですべての実行ファイルで使用することもできます。

# cluster-specific settings [mysql_cluster] ndb-connectstring=ndb_mgmd.mysql.com:1186

my.cnf

ファイルで設定できる他の NDB

変数については

項4.2.3. 「システム変数」

を参照してください。

設定ファイルはデフォルトで

config.ini

の名前になっています。設定ファイルは起動時に

ndb_mgmd

で読み込まれどこにでも配置できます。そのロケーションと名前は

ndb.mgmd のコマンドラインにある

--config-file=

を使用して指定できます。設定ファイルが指定されていない場合、ndb_mgmd

がデフォルトで現在の動作中のディレクトリにある

path_nameconfig.ini

ファイルを読み込もうとします。

現在設定ファイルは INI

フォーマットで、最初にセクションの見出しのあるセクション(角括弧で括られている)で構成され、その後に適切なパラメータ名や値が続きます。標準の

INI

フォーマットと違うところはパラメータ名や値がコロン

(‘:’) および等号記号

(‘=’)

で分離できることです。もう一箇所違うところはセクションがセクション名で独自に認識されないことです。その代わり、独自のセクション

(同じ種類の異なる 2 つのノードなど)

はセクション内のパラメータとして指定された独自の

ID で認識されます。

デフォルト値は殆どのパラメータに定義され、config.ini

で指定することもできます。デフォルト値のセクションを作成するには、単に単語

DEFAULT

をセクション名に追加するだけです。例えば、[NDBD]

セクションは特定のデータノードに適用されるパラメータを含み、[NDBD

DEFAULT]

セクションはすべてのデータノードに適用されるパラメータを含みます。すべてのデータノードが同じデータのメモリ容量を使用するものと仮定します。それらをすべて設定するには、DataMemory

ラインを含む [NDBD DEFAULT]

セクションを作成してデータのメモリ容量を指定します。

最低の設定でも、設定ファイルはクラスタに使用されるコンピュータやノードを定義し、それらのコンピュータのこれらのノードが属します。1 台のマネジメント サーバー、2 台のデータノードおよび 2 台の MySQL サーバーで構成した簡素な設定ファイルの例をここに示します。

# file "config.ini" - 2 data nodes and 2 SQL nodes # This file is placed in the startup directory of ndb_mgmd (the # management server) # The first MySQL Server can be started from any host. The second # can be started only on the host mysqld_5.mysql.com [NDBD DEFAULT] NoOfReplicas= 2 DataDir= /var/lib/mysql-cluster [NDB_MGMD] Hostname= ndb_mgmd.mysql.com DataDir= /var/lib/mysql-cluster [NDBD] HostName= ndbd_2.mysql.com [NDBD] HostName= ndbd_3.mysql.com [MYSQLD] [MYSQLD] HostName= mysqld_5.mysql.com

各ノードはそれぞれ独自のセクションを

config.ini

に持つ必要があります。例えば、このクラスタには

2

台のデータノードがあるので、前述の設定ファイルにはこれらのノードを定義する

2 つの [NDBD]

セクションがあります。

以下のリストに示すように、config.ini

設定ファイルで使用できる異なる 6

つのセクションがあります。

[COMPUTER]:クラスタのホストを定義します。これは実際の MySQL クラスタの設定には必要ありませんが、大きなクラスタを設定する際に使用すると便利です。詳細については、項14.4.4.3. 「クラスタ コンピュータの定義」 をご参照してください。[NDBD]:クラスタ データノード (ndbd プロセス) の定義します。詳細は、項14.4.4.5. 「Defining Data Nodes」 を参照してください。[MYSQLD]:クラスタ MySQL サーバーノード (SQL または API ノードとも呼ばれている) を定義します。SQL ノード設定の説明については 項14.4.4.6. 「SQL および他の API ノードの定義」 を参照してください。[MGM]あるいは[NDB_MGMD]:クラスタ マネジメント サーバー (MGM) ノードを定義します。MGM ノードの設定に関する情報は 項14.4.4.4. 「マネジメント サーバーの定義」 を参照してください。[TCP]:TCP/IPがデフォルトの接続プロトコルの場合のクラスタ ノード間の TCP/IP 接続を定義します。通常、[TCP]あるいは[TCP DEFAULT]セクションは、クラスタが自動的にこれを行うので MySQL Cluster の設定には必要はありませんが、クラスタにより提供されたデフォルトをオーバーライドする際に必要になる場合があります。利用できる TCP/IP の設定パラメータおよびその使用方法については 項14.4.4.7. 「Cluster TCP/IP Connections」 を参照してください。(項14.4.4.8. 「直接接続を使用した TCP/IP の接続」 にもこのTCP/IP に関する情報を載せてあります。)[SHM]:ノード間の共有メモリの接続を定義します。MySQL 5.1 では、それはデフォルトで有効になっていますが現在はまだ試験段階です。SHM のインターコネクトの説明に付いては 項14.4.4.9. 「共有メモリ接続」 を参照してください。[SCI]:クラスタノード間のスケーラブル コヒーラント インターフェースの接続を定義します。そのような接続に MySQL Sluster のディストリビューションには含まれていないが、自由に入手できるソフトウェアと特定のハードウェアが必要です。SCI のインターコネクトに関する詳細は 項14.4.4.10. 「SCI トランスポート接続」 を参照してください。

各セクションに対して DEFAULT

の値を定義できます。すべてのクラスタのパラメータは重要なパラメータで、my.cnf

あるいは my.ini

ファイルで指定されたパラメータとは異なります。

MySQL Cluster マネジメント サーバー (ndb_mgmd) を除いて、MySQL Cluster の一部を構成する各ノードはマネジメント サーバーのロケーションをポイントする接続文字列 が必要です。この接続文字列はマネジメント サーバーへの接続の確立およびクラスタのノードの役割に基づいた他のタスクの実行に使用されます。接続文字列の構文は以下のようになります。

<connectstring> :=

[<nodeid-specification>,]<host-specification>[,<host-specification>]

<nodeid-specification> := node_id

<host-specification> := host_name[:port_num]

node_id は 1 より大きい整数で

config.ini

のノードを認識します。host_name

は文字列で有効なインターネットのホスト名あるいは

IP

アドレスを表します。port_num

は整数で TCP/IP ポート番号を意味します。

example 1 (long): "nodeid=2,myhost1:1100,myhost2:1100,192.168.0.3:1200" example 2 (short): "myhost1"

すべてのノードは localhost:1186

を他に無い場合デフォルトの接続文字列として使用します。port_num

が接続文字列に無い場合、デフォルトのポートは

1186 です。このポートはこの目的のために IANA

に割り当てられているので、常にネットワークで利用できる状態でなければなりません(詳細は

http://www.iana.org/assignments/port-numbers

参照 )。

複数の <host-specification>

値を入力すると、いくつかの冗長マネジメント

サーバーを指定できます。クラスタのノードは指定された順序で各ホストのマネジメントサーバーに接続が確立されるまで接続を試みます。

接続を指定する多くの異なる方法があります。

各実行ファイルにはそれ自身のコマンドラインのオプションがあり、起動時にマネジメント サーバーを指定します。(それぞれの実行ファイルについてはその説明書を参照してください。)

接続文字列をマネジメント サーバー

my.cnfファイルの[mysql_cluster]セクションに置くことで接続文字列をクラスタのすべてのノードに一度に設定することもできます。以前のバージョンへの互換性につい打ては、同じ構文を使用して他の 2 つのオプションが利用できます。

NDB_CONNECTSTRING環境変数を設定して接続文字列を含みます。各実行ファイルに接続文字列を書きそれを

Ndb.cfg名のテキスト ファイルに入れこのファイルを実行ファイルの起動ディレクトリに入れます。

しかし、これらは現在あまり利用されていないため新しいインストールには使用されません。

接続文字列の指定で推奨している方法は接続文字列をコマンドラインに設定するかあるいは各実行ファイルの

my.cnf ファイルで設定します。

[NDB_MGMD]

セクションはマネジメント

サーバーの振る舞いを設定するために使用します。[MGM]

が別名として使用されます。この 2

つのセクション名は同じです。以下のリストのすべてのパラメータはオプションで省略されるとデフォルトの値になります。注:ExecuteOnComputer

または HostName

パラメータのどちらも存在しない場合、デフォルトの値

localhost

がその両方の値に使用されます。

クラスタの各ノードにはそれぞれ一意の ID があり、1 〜63 の整数値で表されます。この ID はすべての内部のクラスタ メッセージでノードを示すために使用されます。

これは

config.iniファイルの[COMPYUTER]セクションで定義されたコンピュータの中の 1 台の コンピュータのidセットの意味します。これはポート番号でこれによりマネジメント サーバーが設定要求およびマネジメント コマンドを受け取ります。

このパラメータを指定するとマネジメント ノードが常駐するコンピュータのホスト名を定義します。

localhost以外のホスト名を指定するには、このパラメータあるいはExecuteOnComputerのいずれかが必要です。このパラメータはクラスタのログインの情報をどこに送るかを指定します。この点に関しては ?

FILEをデフォルトとしてCONSOLE、SYSLOG? およびFILEの 3 つのオプションがあります。CONSOLEはログをstdoutに出力します。CONSOLE

SYSLOGはログをsyslogファシリティに送ります。可能な値はこれらauth、authpriv、cron、daemon、ftp、kern、lpr、mail、news、syslog、user、uucp、local0、local1、local2、local3、local4、local5、local6あるいはlocal7の内の1つです。注:すべてのファシリティが必ずしもすべてのオペレーティング システムでサポートされる必要はありません。

SYSLOG:facility=syslog

FILEクラスタのログ出力を同じマシンの通常のファイル送ります。以下の値を指定できます。filename:ログ ファイルの名前です。maxsize:ファイルがロールオーバーして新しいファイルに切り替わる前の最大サイズ (バイト表示)。これが起こると、古いログ ファイルはファイル名に.Nが付いたファイル名に変わります。Nはこの名前でまだ使用されていない次の番号になります。maxfiles:ログ ファイルの最大数です。

FILE:filename=cluster.log,maxsize=1000000,maxfiles=6

FILEパラメータのデフォルトの値はFILE:filename=ndb_です。node_id_cluster.log,maxsize=1000000,maxfiles=6node_idはノードの ID です。

以下に示すようにセミコロンで区切って複数のログ ディスティネーションを指定できます。

CONSOLE;SYSLOG:facility=local0;FILE:filename=/var/log/mgmd

このパラメータはどのノードがアービトレーターとしての役割を果たすかを定義します。MGM ノードおよび SQL ノードのみがアービトレーターになれます。

ArbitrationRankは以下の値の 1 つを取ることができます。0: このノードはアービトレーターとしては使用されません。1: このノードは優先度が高く、つまり、低い優先度のノードに対してアービトレーターとしての優先されます。2: は優先度の低いノードを意味し、優先度の高いノードがその目的に利用できないときにのみアービトレーターとして使用されます。

通常、マネジメント サーバーはその

ArbitrationRankで 1 (デフォルトの値) でアービトレーターとして設定され、SQL ノードは 0 に設定されます。マネジメント サーバーのアービトレーションの要求への応答をミリセカンドの数値で遅延させる整数値ですデフォルトではこの値は 0 です。通常はこの値を変更する必要はありません。

これはマネジメント サーバーの出力ファイルを格納するディレクトリを指定します。これらのファイルはクラスタ ログ ファイル、プロセス出力ファイル、およびデーモンのプロセス ID (PID) ファイルを含んでいます。(ログ ファイルでは、このロケーションはこの項で以前説明したように

FILEパラメータをLogDestinationに設定すると書き換えらえます。このパラメータのデフォルトの値はディレクトリで、その中に ndb_mgmd があります。

[NDBD] および [NDBD DEFAULT]

セクションはクラスタのデータノードの振る舞いを設定するために使用されます。バッファ

サイズ、プール

サイズ、タイムアウトなどを管理する多くのパラメータがあります。唯一必須のパラメータは:

ExecuteOnComputerあるいはHostNameのいずれかは、[NDBD]セクションで定義される必要があります。パラメータ

NoOfReplicasはそれがすべてのクラスタ データ ノードに共通なため、 [NDBD DEFAULT] セクションで定義する必要があります。

ほとんどのデータ ノードのパラメータは

[NDBD DEFAULT]

セクションで設定されます。ローカル値を設定できる明示的に指定されたパラメータのみが

[NDBD]

セクションで変更できます。存在する場合、HostName、Id

および ExecuteOnComputer

はローカルの [NDBD]

セクションで定義され、config.ini

の他のセクションでは定義されません。換言すれば、これらのパラメータは

1 つのデータ ノード固有のものです。

メモリの使用およびバッファ

サイズに影響を及ぼすパラメータは、K、M、あるいはG

を 1024、1024×1024、あるいは

1024×1024×1024

の単位を示す接尾辞として使用できます。

(例えば、100K は 100 × 1024 =

102400

の意味です。)パラメータ名および値は現在ケース

センシティブです。

Id 値 (つまり、データ

ノードの識別子)

はノードが起動されたときあるいは設定ファイルでコマンドラインに割り当てることができます。

これはすべてのクラスタの内部メッセージのノードのアドレスとして使用されるノード ID です。これは 1 〜 63 までの整数です。クラスタの各ノードは一意の ID を持つ必要があります。

これは

[COMPUTER]セクションで定義されたコンピュータのldセットです。このパラメータを指定するとデータ ノードが常駐するコンピュータのホスト名を定義します。

localhost以外のホスト名を指定するには、このパラメータあるいはExecuteOnComputerのいずれかが必要です。クラスタの各ノードは他のノードに接続するためにポートを使用しています。このポートはまた接続設定段階の非 TCP トランスポーターに使用されています。デフォルトのポートは同じコンピュータ上の 2 つのノードが同じポート番号を受信しないようにダイナミックに割り当てられているため、通常このパラメータの値を指定する必要はありません。

このグローバル パラメータは

[NDBD DEFAULT]セクションでのみ設定され、クラスタに保持された各テーブルのレプリカを番号を定義します。このパラメータはまたノード グループのサイズを指定します。ノード グループはすべて同じ情報を保持した一連のノードです。ノード グループは明示的に形成されます。最初のノード グループは最も低いノード ID を持つデータ ノードのセットで形成され、次のノード グループは次に最も低いノード ID のデータ セットで形成されます。参考例として、

NoOfReplicasが 2 に設定された 4 つのデータ ノードがあるとします。その 4 つのデータ ノードのノード ID を 2, 3, 4 および 5 とします。すると最初のノード グループはノードの 2 および 3 から形成され、2 番目のノード グループのノードは 4 と 5 になります。同じノード グループのノードは同じコンピュータには使用しないようにクラスタを設定する必要があります。というのは、1 つのハードウェアの不具合がクラスタ全体のクラッシュにつながるからです。ノード ID が提供されていない場合、データノードの順序はノード グループの決定要素になります。明示の割り当てがされるされないに拘わらす、それらはマネジメント クライアントの

SHOWステートメントの出力に表示されます。NoOfReplicasにはデフォルトの値はありません。最大の可能な値は 4 です。重要このパラメータの値はクラスタのデータ ノード数に同等に分けられる必要があります。例えば、2 つのデータ ノードがあるとすると、

NoOfReplicasは 1 あるいは 2 のいずれかに同じで、2/3 および 2/4 は両方とも機能的な値になります。4 つのデータ ノードがあるとすると、NoOfReplicasは 1、2、あるいは 4 に同じになります。このパラメータはトレース ファイル、pid ファイルおよびエラーファイルを格納するディレクトリを指定します。

このパラメータはメタデータ、REDO ログ、UNDO ログおよびデータ ファイルに作成されたすべてのファイルを格納するディレクトリを指定します。デフォルトは

DataDirで指定されたディレクトリです。注:このディレクトリは ndbd プロセスが実行される前に存在する必要があります。MySQL Cluster の推奨されるディレクトリの階層には

/var/lib/mysql-clusterが含まれます。そこでノードのファイル システムのディレクトリが作成されます。このサブディレクトリの名前にはノード ID が含まれます。例えば、ノード ID が 2 の場合、このサブディレクトリの名前はndb_2_fsとなります。このパラメータはバックアップを格納するディレクトリを指定します。省略された場合、デフォルトのバックアップ ロケーションは

FileSystemPathパラメータで指定されたロケーションの下のBACKUPの名前のディレクトリになります。(上記参照。)

DataMemory および

IndexMemory は [NDBD]

パラメータで、実際のレコードおよびそれらのインデックスを保持するメモリ

シグメントのサイズを指定します。これらの値を設定する際に、DataMemory

および IndexMemory

がどのように使われるかを知っておくことが重要です。なぜなら、それらはクラスタの実際の使用を反映して更新される必要があるからです。

このパラメータはデータベースのレコードを保持するスペース(バイト表示)を定義します。この値で指定される全体量はメモリで割り当てられます。ですからマシンにそれを収容できる十分な物理メモリがあることが非常に重要です。

DataMemoryで割り当てられたメモリは実際のレコードおよびインデックスの保持に使用されます。各レコードには 16 バイトのオーバーヘッドがあります。各レコードはそれが 32KB ページで 128 バイト ページのオーバーヘッドに保持されるのでさらに使用できないスペースが増えます。 (下参照)。各レコードは 1 ページにしか保存されないので、各ページ毎に使用できないスペース少しずつあります。MySQL 5.1 の可変サイズ テーブル属性により、データは

DataMemoryから割り当てられた個別のデータページに保持されます。可変長レコードには 4 バイトのオーバーヘッドの固定サイズ部分を使用し可変サイズ部分を参照します。可変サイズ部分には 2 バイトのオーバーヘッドと属性毎に 2 バイトのオーバーヘッドがあります。最大のレコード サイズは現在 8052 バイトです。

DataMemoryで定義されたメモリ スペースは、レコード毎に 10 バイトを使用する順序付けされたインデックスの保持にも使用されます。各テーブル行は順序づけされたインデックスで表されます。ユーザー間での共通のエラーはすべてのインデックスはIndexMemoryで割り当てられたメモリに保持されるためと想定できるが、これがすべてではありません。プライマリ キーと一意のハッシュ インデックスのみがこのメモリを使用します。順序付けされたインデックスはDataMemoryで割り当てられたメモリを使用します。しかし、プライマリ キーあるいは一意のハッシュ インデックスを作成すると インデックス作成ステートメントのUSING HASHを指定しない限り同じキーで順序付けされたインデックスも作成されます。これはマネジメント クライアントの ndb_desc -ddb_nametable_nameを実行してと検証できます。DataMemoryで割り当てられたメモリ スペースはテーブル フラグメントに割り当てられた 32KB のページで構成されます。各テーブルはクラスタにデータ ノードがあるため通常同じ数のフラグメントにパーテッションされます。このように、各ノードに対して、NoOfReplicasで設定された同数のフラグメントがあります。ページが割り当てられると、テーブルを削除する以外にフリーページのプールに戻すことは現在できません。(このことは

DataMemoryページが一度所定のテーブルに割り当てられると他のテーブルで使用できないということを意味しています。)すべてのレコードが他の生きたノードから空のパーティッションに挿入されるため、ノードのリカバリを実行するとパーテッションを圧縮します。DataMemoryメモリ スペースはまた UNDO 情報を含んでいます。更新毎に、変更されないレコードのコピーがDataMemoryで割り当てられます。順序付けされたテーブル インデックスに各コピーの参照があります。一意のハッシュ インデックスは一意のインデックスのカラムが更新されたときのみ更新されます。その場合、インデックス テーブルでの新しいエントリが挿入されその挿入によって古いエントリは削除されます。このため、クラスタを使用したアプリケーションの大きなトランザクションを扱うのに十分なメモリを割り当てることも重要です。いずれにしても、いくつかの大きなトランザクションを実行することは、以下の理由によって多くの小さなトランザクションを実行するのに対して優位性がある訳ではありません。大きなトランザクションは小さなトランザクションより早い訳ではない

大きなトランザクションは失われるオペレーション数が増えるので、トランザクションが失敗した場合には繰返す必要がある

大きなトランザクションは多くのメモリを使用する

DataMemoryのデフォルトの値は 80MBです。最小は 1 MB です。最大サイズはありませんが、現実的には制限に達したときプロセスがスワップしないように最大サイズを決める必要があります。制限はマシンで利用できる物理 RAM の容量およびオペレーティング システムがプロセスの実行に必要な容量によって決まります。32 ビットのオペレーティング システムは一般的にはプロセス毎では 2?4GB ですので、64 ビットのオペレーティング システムはさらに多くのメモリを使用できます。この理由により大きなデータベースの場合、64 ビットのオペレーティング システムの使用が望まれます。このメモリは MySQL のハッシュ インデックスに使用されるストレージ量を管理します。ハッシュ インデックスは常にプライマリ キーのインデックス、独自のインデックス、および独自の制約に使用されます。プライマリ キーおよび独自のインデックスを定義する際、2 つのインデックスが作成され、その 1 つがすべての tuple アクセスおよびロックの取扱いに使用されるハッシュのインデックスです。それはまた独自の制約の強化にも使用されます。

ハッシュ インデックスのサイズはレコード毎に 25 バイトで、それにプライマリ キーのサイズが加わります。32 バイト以上のプライマリ キーには別に 8 バイト追加されます。

IndexMemoryのデフォルトの値は 18MB です。最低は 1MB です。このパラメータは例えばテーブル名などの文字列に使用されるメモリ容量に割り当てを決定し、

config.iniの[NDBD]あるいは[NDBD DEFAULT]セクションで指定されます。0および100の間の値は最大のデフォルトの値のパーセントで、テーブル数、最大のテーブル名のサイズ、最大の.FRMファイル、MaxNoOfTriggers、最大のカラム名のサイズ、および最大のデフォルトのカラムの値などを含む多くの要素に基づいて算出されます。一般的には1000 のテーブルを持つ MySQL Cluster の場合の最大のデフォルト値はおよそ 5 MB にすると安全です。100より大きい値はバイト数を意味します。デフォルトの値が

5? の場合、つまりデフォルトの最大の 5 パーセントあるいはおよそ 5 KB です。(これが MySQL Cluster の以前のバージョンからの変更点です。)ほとんどの環境で、そのデフォルト値で十分ですが、非常に大きなクラスタ テーブル (1000 あるいはそれ以上) の場合、エラー 773 が出る場合があります。文字列メモリで、StringMemory config のパラメータを変更してください。恒久的なエラー:スキーマのエラー で、この場合この値を「増やします。

25(25 パーセント) でも良いでしょう。これですべてのしかも最も極端が場合のエラーの再発を妨げる必要があります。

以下の例でテーブルにメモリがどのように使用され手いるか説明します。このテーブルの定義を考慮します。

CREATE TABLE example ( a INT NOT NULL, b INT NOT NULL, c INT NOT NULL, PRIMARY KEY(a), UNIQUE(b) ) ENGINE=NDBCLUSTER;

各レコードには 12 バイトのデータと 12

バイトのオーバーヘッドがあります。無効なカラムを無くすと

4

バイトのオーバーヘッドを節約できます。さらに、カラム

a と b

にレコード毎におよそ 10

バイト使用する順序付けされた 2

つのインデックスがあります。ベース

テーブルにレコード毎におよそ 29

バイト使用するプライマリ キーのハッシュ

インデックスがあります。独自の制約はプライマリ

キーとして b

およびカラムとして a

を持つ個別のテーブルにより課されます。この他のテーブルは

example

テーブルでさらにレコード毎に 29

バイトのインデックス メモリおよびレコード

データに 8 バイトおよびオーバーヘッドに 12

バイト使用します。

このように、100 万のレコードでは、プライマリ キーと独自の制約のハッシュ インデックス処理に 58MB のインデックス メモリが必要です。さらに、ベース テーブルと独自のインデックス テーブル、および 2 つの順序付けされたインデックス テーブルのレコードに 64MB 必要です。

この様にハッシュ インデックスはかなりのメモリ スペースを必要としますが、その代わりに高速のデータ アクセスを提供します。それらはまた独自の制約を処理するために MySQL で使用されています。

現在、パーテッション アルゴリズムはハッシュのみで順序付けされたインデックスは各ノードに対してローカルです。このように、順序付けされたインデックスは一般的には独自の制約の処理には使用できません。

IndexMemory および

DataMemory

の重要な点は、各ノード

グループのデータベース

サイズの合計はすべてのデータ

メモリおよびすべてのインデックス

メモリの合計であるということです。各ノード

グループはレプリケート (複製)

された情報の保持に使用されますので、 2

つのレプリカを持つ 4 つのノードがあれば、2

つのノード

グループがあることになります。このように、利用可能なデータ

メモリの合計は各データ ノードに対して 2

× DataMemory です。

DataMemory と

IndexMemory

を全てのノードに対して同じ値で設定するよう強くお勧めします。クラスタではデータの配布はすべてのノードで同一ですので、各ノードの最大利用可能スペースはクラスタで一番小さいノード スペースより大きくなることはできません。

DataMemory と

IndexMemory

は変更できますが、これらのいずれかを少なくすることは危険で、そうすることによってノードあるいは

MySQL Cluster 全体がメモリ

スペースの不足によって再起動できなくなります。これらの値を増やすことは容認できますが、そのようなアップグレードをする場合にはソフトウェアのアップグレードと同じ方法で、つまり設定ファイルのアップグレード、次に各データ

ノードを順番に再起動してからマネジメント

サーバーを再起動するようお勧めします。

アップグレードによって使用できるインデックス メモリの量は増えません。挿入は直ぐできます。しかし、行はトランザクションが実施されるまで実際は削除されません。

これから説明する次の 3 つの

[NDBD]

パラメータは重要です。なぜなら、それらはシステムが処理する並列トランザクション数およびトランザクションのサイズに影響を及ぼすからです。MaxNoOfConcurrentTransactions

はノードで可能な並列トランザクション数を設定します。MaxNoOfConcurrentOperations

は更新段階およびあるいは同時ロック時のレコード数を設定します。

これらのパラメータはどちらも (特に

MaxNoOfConcurrentOperations は)

特定の値をしかもデフォルトの値を使用しないで設定する

ユーザーにとっては目標値になると思われます。デフォルトの値はこれらの値が過剰なメモリを使用しないように確認するために、小さなトランザクションを使用してシステムに設定されます。

クラスタのアクテイブなそれぞれトランザクションはクラスタ ノードの 1 つにレコードを持つ必要があります。協調的なトランザクションはノード間で実行されます。クラスタのトランザクション レコードの合計数はクラスタの所定のノードのトランザクション数にノードを乗算した数になります。

トランザクション レコードは個々の MySQL サーバーに割り当てられます。通常は、少なくてもクラスタのテーブルを使用している少なくても 1 つのトランザクション レコードが接続毎に割り当てられます。このため、クラスタのトランザクション レコード数がクラスタの すべての MySQL サーバーに同時接続している数よりも多いことを確認する必要があります。

このパラメータは全てのクラスタ ノードに対し同じ値を設定する必要があります。

このパラメータを変更することは安全ではなく、変更することによってクラスタがクラッシュする場合があります。ノードがクラッシュすると、ノードの 1 つ (実際は一番最後までクラッシュしないで残ったノード) がクラッシュしたときにクラッシュしたノードで進行中のすべてのトランザクションの状態に戻します。ですからこのノードが失敗したノードの出来るだけ多くのレコードを持っていることが重要です。

デフォルトの値は 4096 です。

このパラメータの値をトランザクション数やサイズに基づいて調整することはいい考えです。少数のオペレーションをそれぞれあまり多くのレコードを使用しないでトランザクションを実行するときには、このパラメータを高く設定する必要はありません。多くのレコードを含む大きなトランザクションを実行するするときにはこのパラメータを高く設定する必要があります。

レコードは各トランザクション毎に記録され、トランザクション コーディネーターおよび実際の更新が行われるノードでクラスタのデータを更新します。このレコードにはロールバック、ロック キュー、およびその他の目的のための UNDO レコードの検索に必要なステート情報が含まれます。

このパラメータはクラスタのデータ ノード数で除算した、トランザクションで同時に更新されるレコードの数に設定する必要があります。例えば、4 つのデータ ノードを持ち 1,000,000 の同時更新をトランザクションで処理するクラスタでは、この値を 1000000 / 4 = 250000 に設定する必要があります。

ロックを設定するクエリの読み込みでもオペレーション レコードが作成されます。ノードへの配布が完全でない場合にそれに対処するためにいくつかの予備のスペースが個々のノード内で割り当てられます。

クエリが独自のハッシュ インデックスを使用する場合、 トランザクションで実際にレコード毎に使用される 2 つのオペレーション レコードがあります。最初のレコードはインデックス テーブルの読み込みを行い、2 番目はベース テーブルのオペレーションを処理します。

デフォルトの値は 32768 です。

このパラメータは個別に設定される 2 つの値を扱います。これらの最初の値はトランザクション コーディネーターに配置するトランザクション レコード数を指定します。2 番目の値はデータベースに対してローカルにするオペレーション レコード数を指定します。

8 つのノードを使用したクラスタで実行される非常に大きなトランザクションのトランザクション コーディネーターにはトランザクションでの読み込み、更新、削除に相当するオペレーション レコードが必要です。しかし、オペレーション レコードは 8 つのノードすべて使用されます。このように、システムを 1 つの非常に大きなトランザクションに設定する必要がある場合には、2 つの部分を個別に設定するほうが良いでしょう。

MaxNoOfConcurrentOperationsはトランザクション コーディネーターのノード部分のオペレーション レコード数の算出に使用されます。オペレーション レコードにはメモリ要件を考慮に入れることも重要です。これらはレコード毎に約 1KB 使用します。

デフォルトでは、このパラメータは 1.1 ×

MaxNoOfConcurrentOperationsで算出されます。これはトランザクションがそれほど大きくない多くのトランザクションを同時に行うシステムに向いています。一度に非常に大きなトランザクションを扱う必要がある場合には、このパラメータを明示的に指定してデフォルト値をオーバーライドするのがいいでしょう。

次の [NDBD] パラメータ

セットはクラスタ

トランザクションの一部のステートメントを実行する際のテンポラリのストレージを決定するために使用されます。すべてのレコードがステートメントが完了しクラスタが実行あるいはロールバックを待っているときにリリースされます。

これらのパラメータのデフォルト値で殆どの状況をカバーします。しかし、多くの行数やオペレーションが絡むトランザクションのサポートが必要なユーザーはシステムの並列効果を高めるためにこれらの値を増やす必要がある場合があります。一方、トランザクション数が少ないアプリケーションのユーザーはメモリを節約するためにその値を下げることができます。

MaxNoOfConcurrentIndexOperations独自のハッシュ インデックスを使用したクエリでは、オペレーション レコードの別のテンポラリ セットがクエリの実行フェーズで使用されます。このパラメータセットはレコードのプール サイズを設定します。このように、レコードはクエリの一部を実行中にのみ割り当てられます。この部分が実行されるとすぐ、レコードがリリースされます。失敗や実行の処理に必要なステートは通常おオペレーション レコードで扱われ、プール サイズはパラメータ

MaxNoOfConcurrentOperationsで設定されます。このパラメータのデフォルトの値は 8192 です。ごく稀に独自のハッシュ インデックスを使用した極端に高い並列仕様においてはこの値を上げる必要があります。DBA がクラスタに高度な並列が要求されないことを確認できる場合、小さい値が可能でメモリを節約できます。

MaxNoOfFiredTriggersのデフォルトの値は 4000 です。これで殆どの状態に十分です。DBA がクラスタの並列仕様が高くないと確認できた場合、場合によっては値を下げることもできます。独自のハッシュ インデックスに影響を及ぼすオペレーションが実行されるとレコードが作成されます。独自のハッシュ インデックスでテーブルにレコードを挿入あるいは削除するあるいは独自のハッシュ インデックスの一部のカラムを更新するとインデックス テーブルの挿入や削除が無効になります。その結果のレコードは完了するためにオペレーションを無効にした元のオペレーションを待つ間にこのインデックス テーブルのオペレーションを代わりをするために使用されます。このオペレーションは短命ですが、それでも一連の独自のハッシュ インデックスのを含むベース テーブルで多くの並列書き込みオペレーションに対応するプールで多数のレコードを必要とします。

このパラメータで影響を受けたメモリはインデックス テーブルの更新や独自にインデックスを読み込むときに無効になったオペレーションの追跡に使用されます。このメモリはこれらのオペレーションのキーおよびカラムの情報を保持するために使用されます。このパラメータの値をデフォルトの値からの変更を必要とするケースは非常に稀です。

TransactionBufferMemoryのデフォルトの値は 1MB です通常の読み込み書き込みのオペレーションは同様のバッファを 1 つ使用します。その使用はもっと短命です。コンパイル時間のパラメータ

ZATTRBUF_FILESIZE(ndb/src/kernel/blocks/Dbtc/Dbtc.hppに表示) は 4000 × 128 バイト (500KB) に設定します。キー情報の同様のバッファは、ZDATABUF_FILESIZE(Dbtc.hppに表示) は 4000 × 16 = 62.5KB のバッファ スペースを含みます。Dbtcはトランザクションのコーディネーションを扱うモジュールです。

Dblqh モジュール

(ndb/src/kernel/blocks/Dblqh/Dblqh.hpp

にあります)

に読み込みと更新に影響を及ぼす追加の

[NDBD]

パラメータがあります。これらはデフォルトで

10000 × 128 バイト (1250KB) および

ZDATABUF_FILE_SIZE 、デフォルトで

10000*16 バイト (およそ 156KB) のバッファ

スペースに設定された

ZATTRINBUF_FILESIZE

を含みます。現在までのところ、これらのコンパイル時間制限を増やすべきだという弊社のユーザーおよび弊社の広範なテストでの結果もありません。

このパラメータはクラスタで実行される並列スキャン数の管理のために使用されます。各トランザクション コーディネーターはこのパラメータに定義された数の並列スキャンを処理します。各スキャンのクエリは並列の全てのパーティションをスキャンすることで実行できます。各パーティション スキャンはパーティションがあるノードのスキャン レコード、このパラメータの値であるレコード数にノード数を乗算したレコード数を使用します。クラスタは

MaxNoOfConcurrentScansスキャンをクラスタの全てのノードと同時に維持する必要があります。スキャンは実際には 2 つのケースで実行されます。この最初のケースはクエリを扱うハッシュあるいは順序付けされたインデックスが存在しないとき、クエリがテーブルのフル ャンを実行することで実行されます。2 番目のケースはクエリをサポートするハッシュ インデックスが無くて順序付けされたインデックスがある場合にスキャンが実行されます。順序付けされたインデックスを使用するということは並列の範囲スキャンを実行することを意味します。その順序はローカルのパーティッションにのみ維持されるので、すべてのパーティッションにインデックスのスキャンが行う必要があります。

MaxNoOfConcurrentScansのデフォルトの値は 256 です。最大値は 500 です。このパラメータはトランザクションのコーディネーターでの可能なスキャン数を指定します。ローカル スキャン数が提供されていない場合、

MaxNoOfConcurrentScansおよびシステムのデータ ノード数の積にによって計算されます。多くのスキャンが完全に並列化されない場合にローカルのスキャン レコード数を指定します。

このパラメータは多くの同時スキャン オペレーションを扱うロック レコード数の計算に使用されます。

デフォルトの値は 64 です。この値は SQL ノードで定義された

ScanBatchSizeと強い関連があります。これは内部のバッファーで個々のノード内およびノード間でメッセージを渡すために使用されます。これを変更する必要は殆ど考えられませんが、設定はできます。デフォルトでは 1MB に設定されます。

これらの [NDBD]

パラメータはログおよびチェックポイントの振る舞いを管理します。

このパラメータはノードの REDO (やり直し) ログ ファイル数を設定し、この様にREDO ロギングにスペースが割り当てられます。REDO ログ ファイルはリングに環状に構成されますので、そのセットの最初および最後のログ ファイル (それぞれ 「頭」 および 「尻尾」 ログ ファイルとも呼ばれる)が一致しないように設定することが非常に重要です。これらが互いにあまりも近づくと、新しいログ レコードのスペースが足りないためにノードが更新に関わるすべてのトランザクションを中断させる場合があります。

REDOログ ファイルはそのログ レコードが挿入されてから 3 回のローカル チェックポイントが完了するまで削除できません。チェックポイントの頻度はこの章の別の場所で説明したように、それ自身の一連の設定パラメータで決定されます。これらのパラメータの相互作用およびその設定については 項14.4.6. 「ローカル チェックポイントのパラメータの設定」 で説明しています。

デフォルトのパラメータ値は 8 ですので 8 セットの 4 16MB ファイルで合計 512MB になります。換言すれば、REDO ログ スペースは 64MB のブロックに割り当てられる必要があります。非常に多くの更新が要求される場合には、REDO ログに十分なスペースを提供するには

NoOfFragmentLogFilesの値は 300 あるいはそれ以上に高く設定する必要があります。チェックポイントが遅く、データベースへの書き込み数がログ ファイルが一杯になりログの尻尾がリカバリの悪化なしにカットできなくなるほど多い場合、すべての更新トランザクションは内部のエラーコード 410 (

Out of log file space temporarily) によって中断されます。この状態はチェックポイントが完了しログの尻尾が前進できるようになるまで続きます。重要このパラメータは 「稼働中」 には変更できません。

--initialを使用してノードを再起動する必要があります。この値をクラスタの稼働中の変更を希望する場合には、動作中のノードを再起動します。このパラメータはオープン ファイルに内部スレッド割り当て上限を設定します。このパラメータの変更が必要な状況が発生した場合にはバグ として報告お願いします。

デフォルトの値は 40 です。

このパラメータは古い値が書き換えられるまでのトレース ファイルの最大数を設定します。トレース ファイルは、どのような理由であれ、ノードがクラッシュすると生成されます。

デフォルトは 25 トレース ファイルです。

次の [NDBD] パラメータ

セットはメタデータ オブジェクトのプール

サイズを定義し、インデックス、イベント、およびクラスタ間のレプリケーションに使用される属性、テーブル、インデックス、およびトリガ

オブジェクトの最大数の定義に使用されます。これらはクラスタへの単なる

「助言」

で、ここに指定されない値は以下のデフォルトの値になります。

クラスタで定義される属性数を定義します。

デフォルトの値は 1000 で、最大の可能な値は 32 です。最大は 4294967039。すべてのメタデータはサーバーで完全にレプリケート (複製) されるため各属性はノード毎に約 200 バイトのストレージを使用します。

MaxNoOfAttributesを設定する前に、将来実行を希望するであろうALTER TABLEステートメントを事前に用意することが重要です。これは クラスタ テーブルでALTER TABLEを実行中に、元のテーブル 3 倍の属性が使用されるからです例えば、テーブルが 100 の属性を必要し、その変更を後で希望する場合、MaxNoOfAttributesの値を 300 に設定する必要があります。希望するすべてのテーブルを問題無く作成できるとして、経験則では念のために一番大きなテーブルで 2 倍の属性をMaxNoOfAttributesに追加します。パラメータを設定した後に実際のALTER TABLEを試してこの数字が十分であるか検証できます。その数字でうまくいかない場合、MaxNoOfAttributesを元の値の数倍に増やしてももう一度試してみます。各テーブル、独自のハッシュ インデックス、および順序付けられたインデックスにテーブル オブジェクトを割り当てられます。このパラメータは全体としてクラスタにテーブル オブジェクトの最大数を設定します。

BLOBのデータ タイプを持つ各属性に対して、ほとんどのBLOBデータを保持するために予備のテーブルが使用されます。これらのテーブルはテーブルの合計数を決める場合に考慮する必要があります。このパラメータのデフォルトの値は 128 です。最小は 8 で最大は 1600 です。各テーブル オブジェクトはおよそノード毎に 20KB を使用します。

クラスタの順番付けされたインデックスに対し、何にインデックスするかおよびそのストレージ セグメントを記述したオブジェクトが 1 つ割り当てられます。デフォルトでは、そのように定義された各インデックスはまた順番付けされたインデックスを定義します。それぞれの独自のインデックスおよびプライマリ キーは順序付けされたインデックスおよびハッシュ インデックスの両方を持っています。

このパラメータのデフォルトの値は 128 です。各オブジェクトはノード毎におよそ 10KB のデータを使用します。

プライマリ キー以外の各独自のインデックスに対して、独自のキーをインデックスの付いたテーブルのプライマリ キーマップする特別なテーブルが割り当てられます。デフォルトでは、順序付けされたインデックスもまた各独自のインデックスに定義されます。これを防ぐには、独自のインデックスを定義する際に

USING HASHオプションを指定する必要があります。デフォルトの値は 64です。各インデックスはノード毎におよそ 15KB 使用します。

内部のトリガの更新、挿入、および削除が各独自のハッシュ インデックスに割り当てられます。(これは 3 つのトリガが各独自のハッシュ インデックスに作成されることを意味します。)しかし、順序付けされた インデックスにはシングルのトリガ オブジェクトのみ必要です。バックアップもまた 3 つのトリガ オブジェクトをクラスタの各通常のテーブルに使用します。

クラスタ間のレプリケーションもまた内部のトリガを使用します。

このパラメータはクラスタのトリガ オブジェクトの最大数を設定します。

デフォルトの値は 768 です。

このパラメータは MySQL 5.1 は使用されない方向にあります。代わりに

MaxNoOfOrderedIndexesおよびMaxNoOfUniqueHashIndexesを使用する必要があります。このパラメータは独自のハッシュ インデックスのみで使用されます。このプールではクラスタで定義された各独自のインデックスに対しレコードが 1 つ必要です。

このパラメータのデフォルトの値は 128 です。

データ ノードの振る舞いも boolean

値に使用された [NDBD]

パラメータ

セットの影響を受けます。これらのパラメータはそれそれ

1 あるいは Y

に設定すると TRUE、および

0 あるいは N

に設定すると FALSE

を指定できます。

Solaris および Linux を含む多くのオペエーティング システムで、プロセスをメモリにロックしてディスクへのスワップを回避することができます。これはクラスタのリアルタイム特性を保証するために使用されます。

MySQL 5.1.15 以降の場合、このパラメータは

0、1、あるいは2のいずれかの整数値を取ります。それぞれ以下の役割があります。0: ロックを無効にします。これはデフォルトの値です。1: メモリをプロセスに割り当てた後にロックを実行します。2: メモリをプロセスに割り当てる前にロックを実行します。

以前は、このパラメータは Boolean でした。

0あるいはfalseはデフォルトに設定で、ロックを無効にしました。1あるいはtrueはメモリが割り当てられたあとのプロセスのロックを有効にしました。重要MySQL 5.1.15 以降では、trueあるいはfalseをもはやこのパラメータに使用できません。以前のバージョンからアアップグレードする場合には、その値を0、1、あるいは2に変更する必要があります。このパラメータはエラーが発生した場合に ndbd プロセスを終了するかあるいは自動的に再起動させるかを指定します。

この機能はデフォルトで有効になっています。

MySQL クラスタのテーブルを テーブルがディスクにチェックポイントされずロギングも発生しないDisklessに指定できます。そのようなテーブルは主メモリにのみ存在します。ディスク無しのテーブルを使用することによってそれらのテーブルのテーブルあるいはレコードのどちらもクラッシュの影響を受けないことを意味しています。.しかし、ディスク無しモードを起動中に、ディスク無しコンピュータで ndbd を実行できます。

重要この機能によりクラスタ 全体 をディスク無しモードで稼動できます。

この機能を有効にすると、クラスタのオンラインバックアップは無効になります。さらに、クラスタの部分的な起動が出来なくなります。

Disklessはデフォルトで無効になっています。この機能はデバッグ バージョンを作成中にのみアクセスでき、そこでエラーをコードの個々のブロックにテストの一部として挿入できます。

この機能はデフォルトで無効になっています。

タイムアウト、インターバル、およびディスク ページングの管理

クラスタ データ

ノードの様々な操作でのタイムアウトやインターバルを指定する多くの

[NDBD]

パラメータがあります。ほとんどのタイムアウトの値はミリセカンドで指定されます。値がミリセカンドでない場合にはその都度説明します。

主スレッドの無限ループのある地点でのスタックを避けるために、「監視」 スレッドが主スレッドをチェックします。このパラメータはチェック間のミリセカンド数を指定します。プロセスが 3 回のチェックの後でも同じ状態が続くようであれば、監視スレッドがそれを停止します。

パラメータは試験用あるいはローカル条件を採用するために簡単に変更できます。それは特にノード単位で指定する意味もないのだがノード単位で指定できます。

デフォルトのタイムアウトは 4000 ミリセカンド (4 秒) です。

このパラメータはクラスタの初期化ルーチンが起動される前のクラスタのすべてのノードが起動するまでの待機時間を指定します。このタイムアウトは必要に応じてクラスタの部分的起動を避けるために使用されます。

デフォルトの値は 30000 ミリセカンド(30 秒) です。0 でタイムアウトを無効にします。この場合クラスタはすべてのノードが利用できる段階で起動します。

クラスタが

StartPartialTimeoutミリセカンドの待機後に起動の用意が出来ても、まだパーティションの状態である場合、クラスタはこのタイムアウトが経過するまで待ちます。デフォルトのタイムアウトは 60000 ミリセカンド (60 秒) です。

データノードがこのパラメータで指定された時間内にその起動シーケンスを完了できない場合、そのノードの起動は失敗します。このパラメータを 0 (デフォルトの値) に設定するとデータ ノードのタイムアウトが適用されないことを意味します。

0 以外の値の場合、このパラメータはミリセカンドで測定されます。極端い大きな量のデータを含むデータ ノードには、このパラメータを大きくします。例えば、数ギガ バイトのデータを含むデータノードの場合、ノードの再起動を実行するには 10?15 分 (つまり、600000 から 1000000 ミリセカンド) が必要になります。

失敗したノードを見つける主な方法の 1 つにハートビートを使用する方法があります。このパラメータはハートビート信号の送受信の頻度を指定します。続けて 3 回ハートビート インターバルに失敗した場合、そのノードはデッドを宣言されます。このように、ハートビート メカニズムを使用した不具合発見の最大の回数はハートビート インターバルの 4 倍です。

デフォルトのハートビート インターバルは 1500 ミリセカンド (1.5 秒) です。.このパラメータを大幅に変更したりまたはノード間で大きく違わないようにします。1 つのノードが 5000 ミリセカンドを使用しそれを監視するノードが 1000 ミリセカンドを使用した場合、明らかにノードは直ちにデッドを宣言されます。このパラメータはオンラインのソフトウェアのアップグレード時に変更できますが、ほんの小さな増分だけです。

各データノードはハートビート信号を各 MySQL サーバー (SQL ノード) に送って接続されていることを確認します。MySQL サーバーがハートビートを時間内に送信できない場合 「デッド」 を宣言され、その場合すべての実行中のトランザクションは完了してすべてのリソースがリリースされます。SQL ノードは以前の MySQL インスタンスで始められたすべての操作が完了するまで再接続できません。この測定の 3 回のハートビート基準は

HeartbeatIntervalDbDbの説明と同じです。デフォルトのインターバルは 1500 ミリセカンド (1.5 秒) です。インターバルは個々のデータ ノード別にすることも出来ます。というのは、各ノードは接続された MySQL サーバーを監視し、他のすべてのデータ ノードから独立しているからです。

このパラメータはその例外で新しいローカルチェックポイントの起動までの待機時間を設定しません。これはむしろ、ローカルチェックポイントは比較的少ない更新が実行されるクラスタでは実行されないことを確認するために使用されます。更新回数が多い多くのクラスタでは、おそらく新しいローカル チェックポイントは前のチェックポイントが完了すると直ぐに開始されるからです。

前のローカル チェックポイントが開始されてから実行されたすべての書き込み操作のサイズが追加されます。このパラメータもその例外で 4 バイトの単語の基数 2 対数で指定されますので、デフォルト値の 20 は 4MB (4 × 220) の書き込み操作を意味し、21 は 8MB で、8 GB の書き込み操作に相当する最大値 31 まで続きます。

クラスタのすべての書き込み操作はが一緒に追加されます。

TimeBetweenLocalCheckpointsを 6 あるいはそれ以下に設定することはローカルのチェックポイントが、クラスタの負荷に関係なく休みなく継続的に実行されることを意味します。トランザクションがコミットされると、データがミラーされているすべてのノードの主メモリでコミットされます。しかし、トランザクションのルグ レコードはそのコミットの一部としてディスクにフラッシュされません。この振る舞いの背後にある論法はトランザクションを少なくとも 2 台の自律型ホスト マシン上で成功裏に実行するには持続性に於ける合理的な基準を満たす必要があるからです。

最悪の場合?クラスタの完全なクラッシュ?でも適切に処理されることを確認することも重要です。これを保証するには、所定のインターバル内に実行されるすべてのトランザクションをグローバル チェックポイントに設定すると、それがディスクにフラッシュされコミットされたとトランザクションのセットとして考慮されます。換言すれば、コミット プロセスの一部として、トランザクションがグローバル チェックポイントに組み入れられます。後でこのグループのログ レコードがディスクにフラッシュされ、トランザクション グループ全体がクラスタのすべてのコンピュータ上のディスクでコミットされます。

このパラメータはグローバル チェックポイント間のインターバルを定義します。デフォルトは 2000 ミリセカンドです。

TimeBetweenInactiveTransactionAbortCheckタイムアウトの処理はこのパラメータで指定されたインターバル毎に各トランザクションのタイマーを一度チェックすることで実行されます。この様に、このパラメータを 1000 ミリセカンドに設定すると、すべてのトランザクションは 1 秒毎にタイムアウトをチェックします。

デフォルトの値は 1000 ミリセカンド (1 秒) です。

このパラメータはトランザクションが中断される前の同じトランザクションのオペレーション間に許容された最大の経過時間を表します。

このパラメータのデフォルトはゼロ (タイムアウト無し) です。トランザクションのロックをあまり長くしないことを確認する必要のあるリアルタイムのデータベースでは、このパラメータは非常に小さい値に設定する必要があります。単位はミリセカンドです。

TransactionDeadlockDetectionTimeoutノードがトランザクションに関わるクエリを実行するとき、そのノードは継続する前にクラスタの他のノードが応答するまで待ちます。応答の失敗は以下の理由のいずれかで起こります。

そのノードが 「デッド」状態にある

オペレーションがロック キュウーの状態にある

アクションの実行をリクエストしたノードが過負荷にある

このタイムアウトのパラメータはトランザクション コーディネーターがトランザクションの中断にいたるまでの別のノードによるクエリを実行するまでの待機時間を示したもので、ノードの中断処理およびデッドロック検知の両方に重要です。その設定が高すぎるとデッドロックおよびノード中断を含む状態において望まない振る舞いを引き起こします。

デフォルトのタイムアウトは 1200 ミリセカンド (1.2 秒) です。

データをローカルのチェックポイント ファイルにフラッシュする前に保持するする最大バイト数です。

デフォルトの値は 4M (4 メガバイト) です。

このパラメータは MySQL 5.1.12 に追加されています。

ローカル チェックポイント中に転送されるデータ量をバイト/秒で表したものです。

デフォルトの値は 10M (10 メガバイト/秒) です。

このパラメータは MySQL 5.1.12 に追加されています。

ローカル チェックポイント中に再起動の操作の一部とし転送されるデータ量をバイト/秒で表したものです。

デフォルトの値は 100M (100 メガバイト/秒) です。

このパラメータは MySQL 5.1.12 に追加されています。

NoOfDiskPagesToDiskAfterRestartTUPローカル チェックポイント実行中に、アルゴリズムがすべてのデータページをディスクにフラッシュします。軽減策なしで単にそのように素早く行うのは過剰な負荷をプロセッサ、ネットワーク、およびディスクにかける場合があります。書き込み速度を管理するために、このパラメータは 100 ミリセカンド毎の書き込みページ数を指定します。ここでは 1 「 ページ」 は 8KB に定義されています。このパラメータは 80KB/秒単位で指定され、

NoOfDiskPagesToDiskAfterRestartTUPを20の値に設定するとローカル チェックポイント中のデータページでのディスクへの書き込み速度 1.6MB/秒を意味します。この値には UNDO ログ レコードのデータ ページへの書き込みが含まれています。つまり、このパラメータはデータ メモリの書き込み数の制限を扱っています。インデックス ページの UNDO ログ レコードはパラメータNoOfDiskPagesToDiskAfterRestartACCで処理されます。(インデックス ページに関する情報IndexMemoryは入力を参照してください。)要するに、このパラメータはローカル チェックポイントをどれだけ速く実施するかを指定します。それは

NoOfFragmentLogFiles、DataMemory、およびIndexMemoryと一緒に使用されます。これのパラメータのインターラクションおよびそれらの適切な値の選択肢に関する情報は、項14.4.6. 「ローカル チェックポイントのパラメータの設定」 を参照してください。

デフォルトの値は 40 (3.2MB/秒のデータ ページ) です。

注:このパラメータは MySQL 5.1.6 では使用頻度が下がっています。それはMySQL 5.1.12 およびそれ以降のバージョンは、 DiskCheckpointSpeed および DiskSyncSize を使用しているからです。.

NoOfDiskPagesToDiskAfterRestartACCこのパラメータは

NoOfDiskPagesToDiskAfterRestartTUPと同じ単位を使用し同じ役割を果たしますが、インデックス メモリからインデックス ページの書き込み速度を制限します。このパラメータのデフォルト値は 20 (1.6MB/秒 のインデックス メモリ ページ)。

注:このパラメータは MySQL 5.1.6 では使用頻度が下がっています。それはMySQL 5.1.12 およびそれ以降のバージョンは、 DiskCheckpointSpeed および DiskSyncSize を使用しているからです。.

NoOfDiskPagesToDiskDuringRestartTUPこのパラメータは

NoOfDiskPagesToDiskAfterRestartTUPおよびNoOfDiskPagesToDiskAfterRestartACCと同じ役割を果たしますが、ノードが再起動されて時にノードで実行されるローカルのチェックポイントに関してのみそのように振舞います。ローカル チェックポイントは常にすべてのノードの再起動の一部として実行されます。ノードの再起動中にはノードで実行される作業量が少ないため他の場合より高速でディスクに書き込みできます。このパラメータはデータ メモリで書き込まれたページをカバーしています。

デフォルトの値は 40 (3.2MB/秒) です。

注:このパラメータは MySQL 5.1.6 では使用頻度が減っています。それはMySQL 5.1.12 およびそれ以降のバージョンは、 DiskCheckpointSpeedInRestart および DiskSyncSize を使用しているからです。.

NoOfDiskPagesToDiskDuringRestartACCノードの再起動時のローカル チェックポイント中にディスク書き込まれるインデックスのメモリ ページ数を管理します。

NoOfDiskPagesToDiskAfterRestartTUPおよびNoOfDiskPagesToDiskAfterRestartACCと同じで、このパラメータ値は 100 ミリセカンド (80KB/秒) で書き込まれた 8KB ページを表します。デフォルトの値は 20 (1.6MB/秒) です。

注:このパラメータは MySQL 5.1.6 では使用頻度が減っています。。それは MySQL 5.1.12 およびそれ以降のバージョンは、 DiskCheckpointSpeedInRestart および DiskSyncSize を使用しているからです。.

このパラメータはデータ ノードのアービトレーターからアービトレーション メッセージへの応答の待機時間を指定します。この待機時間を過ぎると、ネットワークは切断されたものとみなされます。

デフォルトの値は 1000 ミリセカンド (1 秒) です。

すべての更新はログに記録する必要があります。REDO ログはこれらの更新をシステムが再起動されたときにはいつでも実行できるようにします。NDB リカバリ アルゴリズムはデータの 「ファジー」 チェックポイントを UNDO ログと一緒に使用し、REDO ログを使用してすべての変更を修復ポイントまで再現します。

RedoBuffer は REDO

ログが書き込まれるバッファのサイズを設定します。デフォルトでは

8MB です。このバッファは REDO

ログのレコードをディスクに書き込む際のファイル

システムへのフロント

エンドとして使用されます。このバッファが小さ過ぎると、NDB

ストレージ エンジンがエラーコード 1221

(REDO log buffers overloaded

を発行します)。

最小値は 1MB

です。ノードがディスク無しの状態で実行されると、ディスクの書き込みが

NDB ストレージ

エンジンのファイルシステム抽出レイヤによって

「フェイク」

されるため、これらのパラメータはペナルティ無しで最小値に設定されます。

重要ローリングの再起動時にこのパラメータを下げることは安全ではありません。

注:MySQL

の以前のバージョンの

UndoIndexBuffer および

UndoDataBuffer パラメータは MySQL 5.1

ではもはや必要なくなりました(あったにしても)。

クラスタの管理においては、様々なイベントに関して

stdout に送られたログ

メッセージ数を管理できることが非常に重要です。各イベント

カテゴリでは、16 の実行可能なイベント

レベル (0〜15 番まで)

あります。イベントのレポートを所定のイベント

カテゴリのレベル 15

設定するとそのカテゴリのすべてのイベント

レポートが stdout

に送られます。0

に設定するとそのカテゴリにはイベント

レポートが無いことを意味します。

デフォルトでは、起動メッセージのみが

stdout

に送られます。残りのイベントレポート

レベルのデフォルトは 0

に設定されます。この理由はこれらのメッセージもまたマネジメント

サーバーのクラスタ

ログに送られるからです。

相似性のレベルをマネジメント クライアントに設定してどのイベント レベルをクラスタ ログでレコードするかを決めることができます。

プロセスの起動時に生成されたイベントのレポート レベルです。

デフォルトのレベルは 1 です。

ノードの優雅なシャットダウンの一部として生成されたイベントのレポート レベルです。

デフォルトのレベルは 0 です。

プライマリ キーの読み込み、更新数、挿入数、バッファ使用に関する情報など統計的なイベントのレポート レベルです。

デフォルトのレベル 0 です。

ローカルおよびグローバル チェックポイントにより生成されたイベントのレポート レベル。

デフォルトのレベルは 0 です。

ノード再起動時に生成されたイベントのレポート レベルです。

デフォルトのレベルは 0 です。

クラスタ ノード間の接続で生成されたイベントのレポート レベルです。

デフォルトのレベル 0 です。

全体としてクラスタによるエラーおよび警告により生成されたイベントのレポート レベルです。これらのエラーはノード障害に結びつくものではないが報告すべきだ思われるエラーです。

デフォルトのレベルは 0 です。

クラスタの一般的な状態に関する情報に生成されたイベントのレポート レベルです。

デフォルトのレベルは 0 です。

この項で説明した[NDBD]

パラメータはオンライン

バックアップの実行用に確保するメモリ

バッファを定義します。

バックアップの作成においては、データをディスクに転送する 2 種類のバッファがあります。バックアップのデータ バッファはノード テーブルのスキャンにより記録されたデータを書き込みむために使用されます。このバッファが

BackupWriteSize(以下参照) で指定されたレベルまで書き込まれると、そのページはディスクに転送されます。データをディスクに書き込んでいる間に、バックアップ プロセスではスペースがなくなるまでこのバッファに書き込みを続けます。スペースが無くなると、バックアップ プロセスがスキャンを停止し、ディスクへに書き込みによってメモリが増えてスキャンを継続できるようになるまで待ちます。デフォルトの値は 2MB です。

バックアップ ログのバッファはバックアップの実行中にそれがすべてのテーブルの書き込みのログ生成に使用されることを除いてバックアップ データ バッファと同様の役割を果たします。同様の原則が、バックアップ ログ バッファにスペースが無いときを除いてバックアップ データ バッファと同じようにこれらの ページの書き込みに適用されて、そのバックアップは失敗します。その理由により、バックアップ ログ バッファのサイズはバックアップ中の書き込みの負荷を処理するだけの十分な大きさが必要です。項14.8.4. 「クラスタ バックアップの設定」 参照。

このパラメータのデフォルトの値は殆どのアプリケーションに十分なものでなければなりません。実際のところ、バックアップの失敗はディスクへの書き込み速度が遅いよりはバックアップ ログ バッファが満杯になることによりよく起こります。ディスクのサブシステムがアプリケーションによる書き込み負荷対応するように設定されていない場合、クラスタは所定の作業を実行できなくなります。

クラスタ ノードの設定ではディスクあるいはネットワーク接続をボトルネックにするよりはプロセッサがボトルネックになるように構成するほうが望まれます。

デフォルトの値は 2MB です。

このパラメータは単純に

BackupDataBufferSizeとBackupLogBufferSizeの合計です。デフォルトの値は 2MB + 2MB = 4MB です。

重要

BackupDataBufferSizeおよびBackupLogBufferSizeの合計が 4MB 以上の場合、このパラメータはconfig.iniファイルでその合計として明示的に設定される必要があります。このパラメータはバックアップ ログおよびバンクアップ データ バッファによってディスクに書き込まれたメッセージのデフォルトサイズを指定します。

デフォルトの値は 32KB です。

このパラメータはバックアップ ログおよびバンクアップ データ バッファによってディスクに書き込まれたメッセージの最大サイズを指定します。

デフォルトの値は 256KB です。

重要これらのパラメータを指定する際は、以下の関係が真であることが必要です。そうでない場合、データ ノードは起動しません。

BackupDataBufferSize >= BackupWriteSize + 188KBBackupLogBufferSize >= BackupWriteSize + 16KBBackupMaxWriteSize >= BackupWriteSize

config.ini ファイルの

[MYSQLD] および [API]

のセクションは MySQL サーバー (SQL ノード)

およびクラスタ

データへのアクセスに使用される他のアプリケーション

(API ノード)

を定義します。表示されたパラメータのどれも必要ありません。コンピュータ名およびホスト名の提供が無い場合、ホストのいずれかが

SQL あるいは API ノードを使用できます。

一般的には、[MYSQLD]

セクションは SQL

インターフェースをクラスタに提供している

MySQL

サーバーを示すために使用され、[API]

セクションはクラスタのデータにアクセスしている

mysqld

プロセスよりはアプリケーションに使用されますが、2

つの名前は実際は同義語です。例えば、[API]

セクションの SQL

サーバーとしての役割を果たしている MySQL

サーバーにパラメータを記入できます。

Id値はすべてのクラスタの内部メッセージのノードを識別するために使用されます。それは 1 〜 63 の整数で、クラスタ無いのすべてのノード ID に対して一意出なければなりません。これは

config.iniファイルの[COMPYUTER]セクションで定義されたコンピュータ (ホスト) のidセットのことを意味します。このパラメータを指定することで SQL ノード (API ノード) が常駐するコンピュータのホスト名を定義します。

localhost以外のホスト名を指定するには、このパラメータあるいはExecuteOnComputerのいずれかが必要です。このパラメータはどのノードがアービトレーターとしての役割を果たすかを定義します。MGM ノードおよび SQL ノードの両方がアービトレーターになれます。0 の値は所定のノードがアービトレータとして使用されないことを意味し、1 の値はアービトレーターとしての優先度が高く、2 の値は優先度が低いことをいみします。通常の設定ではマネジメント サーバーをアービトレーターとして使用し、

ArbitrationRankを 1 (デフォルトt) に、すべての SQL ノードに対しては 0 に設定します。この値を 0 (デフォルト) 以外に設定するとアービトレーション要求に対するアービトレーターの応答は指定されたミリセカンド数によって遅延されます。通常この値を変更する必要はありません。

インデックスのフル テーブルあるいは範囲スキャンに翻訳されたクエリに対しては、レコードを適切なサイズで取り出すことがベスト パフォーマンスには重要です。適切なサイズをレコード数 (

BatchSize) およびバイト (BatchByteSize) の両方で設定できます。実際のバッチ サイズは両方のパラメータで制限されます。クエリが実行去れる速度はこのパラメータの設定によって 40% 以上変化します。今後のリリースでは、MySQL Server にクエリのの種類に基づいた適切なバッチ サイズに関するパラメータの設定を取り入れます。

このパラメータはバイト数で測定され、そのデフォルトの値は 32KB です。

このパラメータはレコード数で測定されそのデフォルトの設定値は 64 です。最大サイズは 992 です。

バッチ サイズは各データ ノードから送られる各バッチのサイズです。多くのスキャンは MySQL Server を並列の多くのノードからデータを余り多く受け取らないようにするために並列で行われます。このパラメータはすべてのノードに対してバッチの合計を制限します。

このパラメータのデフォルトの値は 256KB です。最大のサイズは 16MB です。

ここに表示しているmySQL

クライアントの SHOW STATUS

を使用して Cluster SQL として実行されている

MySQL サーバーから情報を入手できます。

mysql> SHOW STATUS LIKE 'ndb%';

+-----------------------------+---------------+

| Variable_name | Value |

+-----------------------------+---------------+

| Ndb_cluster_node_id | 5 |

| Ndb_config_from_host | 192.168.0.112 |

| Ndb_config_from_port | 1186 |

| Ndb_number_of_storage_nodes | 4 |

+-----------------------------+---------------+

4 rows in set (0.02 sec)

これらの Cluster システムのステータス変数に関する情報は、項4.2.5. 「ステータス変数」 を参照してください。

TCP/IP は MySQL Cluster

の接続を確立するデフォルトのトランスポート

メカニズムです。通常はCluster

が自動的に各ノード間、各データ

ノード間および MySQL

サーバーノード、および各データ

ノード間さらには各データ

ノードとマネジメント

サーバーの接続を設定しますので接続を定義する必要はありません。(この規則に対する

1 つの例外については、

項14.4.4.8. 「直接接続を使用した TCP/IP の接続」

を参照)config.ini ファイルの

[TCP]

セクションでクラスタのノード間の TCP/IP

接続を明示的に定義しています。

デフォルトの接続パラメータをオーバーライドするときにのみ接続を定義する必要があります。そのような場合、少なくとも

NodeId1、NodeId2、および変更するパラメータを定義する必要があります。

これらのパラメータのデフォルトの値を

[TCP DEFAULT]

セクションで設定することで変更することもできます。

2 つのノード間での接続を認識するには設定ファイルの

[TCP]セクションでそれらのノード ID を提供します。これらは 項14.4.4.6. 「SQL および他の API ノードの定義」 の説明にあるようにそれぞれのこれらのノードに対して同じ一意Id値をしています。TCP トランスポーターはオペレーティング システムに送信呼び出しを実行する前にバッファを使用してすべてのメッセージを保存します。このバッファが 64KB になると、そのコンテンツを送信します。これらはまた一通りのメッセージが完了すると送信されます。一時的な過負荷状態を処理するために、大きな送信バッファを定義することも出来ます。送信バッファのデフォルトのサイズは 256KB です。

配布されたメッセージのダイアグラムを調べるには、各メッセージを認識する必要があります。このパラメータを

Yに設定すると、メッセージ ID がネットワーク上に転送されます。この機能は生産ビルドでデフォルトによって無効にできます。-debugビルドで有効にします。このパラメータはブール パラメータ (

Yあるいは1に設定して有効にする。無効にするにはNあるいは0) に設定します。デフォルトでそれを無効に出来ます。有効にすると、すべてのメッセージのチェックサムが送信場ファに格納される前に計算されます。この機能によりメッセージが送信バッファで待機している間に、あるいは転送メカニズムで転化してないか確認します。これは他のノードの接続の確認に使用されるポート番号を正式に指定します。このパラメータはもはや使用されません。

データを TCP/IP ソケットから受信するときにバッファのサイズを指定するために使用されます。メモリを節約するとき以外に、このパラメータをそのデフォルトの値の 64KB からめったに変更する必要はありません。

データノード間の直接接続を使用してクラスタを設定するにはクラスタ

config.ini の [TCP]

セクションで接続されているデータノードの交差

IP

アドレスを明示的に指定する必要があります。

以下の例では、それぞれマネジメント

サーバー、SQL ノード、および 2

つのデータノードを持つ少なくとも 4

台のホストを持つクラスタを説明します。そのクラスタは全体として

LAN の172.23.72.*

サブネットに常駐します。通常のネットワーク接続に加えて、2

つのデータノードを標準の交差ケーブルを使用して直接接続し、以下の範囲の

1.1.0.* の IP

アドレスを使用して直接お互いに通信します。

# Management Server [NDB_MGMD] Id=1 HostName=172.23.72.20 # SQL Node [MYSQLD] Id=2 HostName=172.23.72.21 # Data Nodes [NDBD] Id=3 HostName=172.23.72.22 [NDBD] Id=4 HostName=172.23.72.23 # TCP/IP Connections [TCP] NodeId1=3 NodeId2=4 HostName1=1.1.0.1 HostName2=1.1.0.2

HostName

パラメータ、そこでは NN

は整数で、TCP/IP

の直接接続を指定する際にのみに使用されます。